Meta、「Llama 3.2」を公開 新たに追加されたビジョンモデルと軽量モデルはどう使える?:Llamaを活用したアプリケーション開発全体を簡素化する「Llama Stack」も発表

Metaは、同社の大規模言語モデルの最新版「Llama 3.2」を提供開始した。中小規模のビジョンモデル(11Bと90B)と、エッジデバイスやモバイルデバイスに搭載可能な軽量のテキスト専用モデル(1Bと3B)をラインアップしている。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

Metaは2024年9月25日(米国時間)、同社の大規模言語モデル(LLM)の最新版「Llama 3.2」を発表した。

7月にリリースした「Llama 3.1」では、80億(8B)、700億(70B)、4050億(405B)パラメーターの3モデルを提供していたのに対し、Llama 3.2では、中小規模のビジョンモデル(11Bと90B)と、エッジデバイスやモバイルデバイスに搭載可能な軽量のテキスト専用モデル(1Bと3B)の計4モデルをラインアップしている。

これらのモデルはllama.comとHugging Faceで公開されており、Metaの幅広いエコシステムを構成するパートナーのプラットフォーム上ですぐに開発に利用できる。これらのパートナーにはAMD、Amazon Web Services、Databricks、Dell Technologies、Google Cloud、Groq、IBM、Intel、Microsoft Azure、NVIDIA、Oracle Cloud、Snowflakeなどが含まれる。

新たに追加されたビジョンモデルはどう使える?

マルチモーダルであるLlama 3.2の11Bおよび90Bモデルは、画像推論のユースケースをサポートしており、チャートやグラフなどの文書レベルの理解、画像のキャプション作成、視覚的グラウンディングタスク(自然言語の記述に基づいて画像内のオブジェクトを方向的に正しく特定するなど)に対応している。

Metaによると、このビジョンモデルでは次のようなタスクを実行可能だという。

- 「前年のどの月に最も売り上げが多かったか」を尋ねると、使用可能なグラフに基づいて推論を行い、素早く回答する

- 「ハイキングコースの中でいつ急な坂道があるか」といった質問に対し、地図を使って推論し、回答する

- 画像の場面を理解し、キャプションとして使える文を1つまたは2つ作成する

エッジデバイスやモバイルデバイスに適した軽量モデル

軽量の1Bおよび3Bモデルは、128Kトークンのコンテキスト長をサポートする。QualcommとMediaTekのハードウェアに対応しており、Armプロセッサに最適化されている。Metaは「エッジでローカルに実行される要約、指示の実行、書き換えといったオンデバイスユースケースにおいて、クラス最先端だ」と述べている。

開発者はこれらのモデルにより、パーソナライズされたエージェント型オンデバイスアプリケーションを構築し、データがデバイス外部に出ることのない強力なプライバシー保護を実現できる。

こうしたアプリケーションにより、受信した直近の10件のメッセージを要約し、行動すべき項目を抽出し、ツール呼び出し機能を使ってフォローアップ会議のカレンダー招待を直接送信するといったことが可能になる。

「Llama Stack」ディストリビューションもリリース

Metaは、初の公式「Llama Stack」ディストリビューションもリリースした。このディストリビューションにより、開発者はシングルノード、オンプレミス、クラウド、オンデバイスなど、さまざまな環境でLlamaを使用する方法を大幅に簡素化でき、セキュリティを統合したRAG(検索拡張生成)やツール対応アプリケーションの迅速な展開が可能になる。

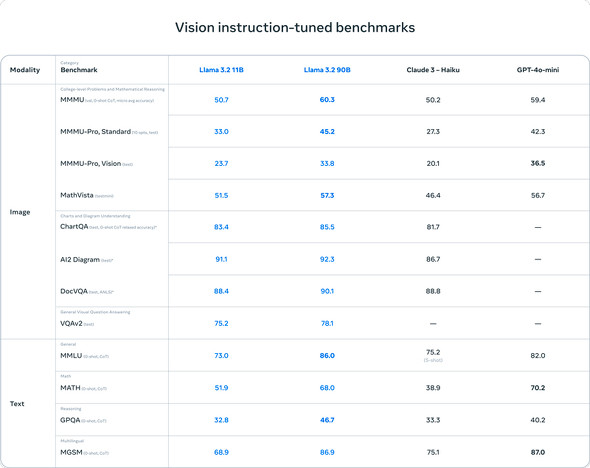

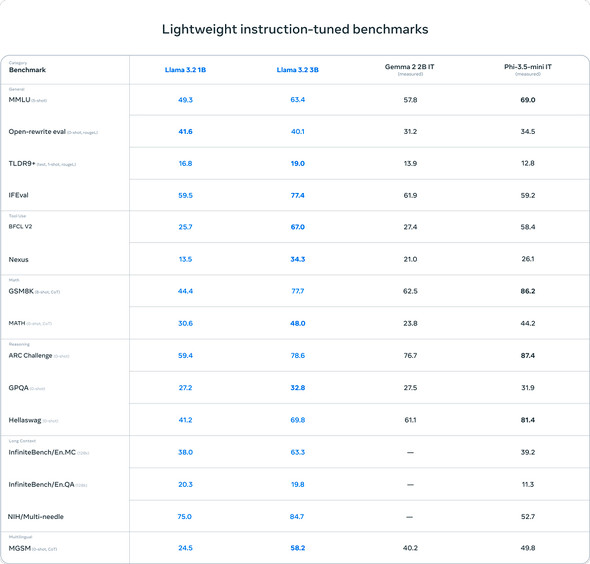

Llama 3.2のベンチマーク

Metaは、自社で行ったベンチマーク評価も公開し、「Llama 3.2のビジョンモデルは、画像認識やさまざまな視覚理解タスクにおける性能が、主要な基盤モデルである『Claude 3 Haiku』や『GPT4o-mini』に匹敵することを示している」と述べている。

また、軽量モデルの3Bは、指示の実行、要約、プロンプトの書き換え、ツールの使用といったタスクでの性能が「Gemma 2 2.6B」および「Phi 3.5-mini」モデルよりも優れており、1Bの性能も「Gemma」に匹敵するとしている。

関連記事

Meta、オープンLLMの最新版「Llama 3.1」を発表 「4050億パラメーターモデル」が利用可能に

Meta、オープンLLMの最新版「Llama 3.1」を発表 「4050億パラメーターモデル」が利用可能に

MetaはオープンLLMの最新版「Llama 3.1」を公開した。llama.meta.comとHugging Faceから無料でダウンロードできる。MetaのCEOであるマーク・ザッカーバーグ氏はLlama 3.1の公開に合わせて声明を発表し、オープンなAIの展望を語った。 Meta、次世代オープンLLM「Meta Llama 3」を発表

Meta、次世代オープンLLM「Meta Llama 3」を発表

Metaは、大規模言語モデル「Meta Llama 3」の8Bおよび70Bパラメーターモデルを発表した。 オープンソースのLLMをローカルで実行できる「Ollama」Windowsプレビュー版、公開

オープンソースのLLMをローカルで実行できる「Ollama」Windowsプレビュー版、公開

Ollama Projectは、オープンソースの大規模言語モデルをローカル環境で実行できる「Ollama」のWindowsプレビュー版を公開した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.