推論コストを10分の1に? NVIDIAが次世代AIプラットフォーム「Rubin」発表:2026年後半にもパートナー企業が製品展開

NVIDIAは、次世代AIコンピューティングプラットフォーム「Rubin」を発表した。前世代のBlackwellと比較して推論トークンの生成コストを最大10分の1に削減し、大規模モデルのトレーニングに必要なGPU数を4分の1に抑えるという。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

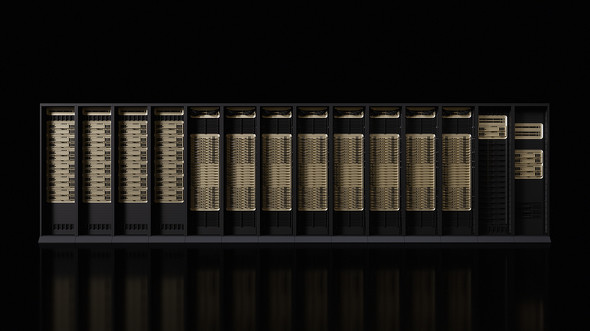

NVIDIAは2026年1月5日(米国時間)、次世代AI(人工知能)プラットフォーム「Rubin」を発表した。

Rubinは、AIスーパーコンピュータを実現するために設計された以下の6つの新しいチップで構成されており、「トレーニング時間を短縮し、推論コストを大幅に削減する」と、NVIDIAは述べている。

- CPU:NVIDIA Vera CPU

- GPU:NVIDIA Rubin GPU

- インターコネクト用スイッチ:NVIDIA NVLink 6 スイッチ

- ネットワークインタフェース:NVIDIA ConnectX-9 SuperNIC

- DPU(データ処理プロセッサ):NVIDIA BlueField-4

- イーサネットスイッチ:NVIDIA Spectrum-6

Rubinプラットフォームの主な特徴は以下の通り。

Rubinプラットフォームの特徴

- Rubinプラットフォームは、ハードウェアとソフトウェアの協調設計により、前世代の「Blackwell」プラットフォームと比較して推論トークンを最大10分の1のコストで提供

- MoEモデル(Mixture of Experts:複数の専門家モデルを組み合わせた大規模AIモデル)のトレーニングに必要なGPU数を4分の1に削減

- 「NVIDIA Spectrum-X Ethernet Photonics」スイッチシステムにより、電力効率と稼働時間を5倍向上

- 「NVIDIA BlueField-4」ストレージプロセッサを搭載した新しい「NVIDIA Inference Context Memory Storage」プラットフォームが、リーズニングを高速化

インテリジェンスの拡張を実現する5つのテクノロジー

Rubinプラットフォームには、エージェント型AIや高度な推論、複雑なビデオ生成ワークロードに対応するための5つの技術が導入されている。

1:第6世代NVIDIA NVLink

大規模なMoEモデルに必要な、高速なGPU間通信を実現する。各GPUは毎秒6TB(テラバイト)の帯域幅を提供し、ラックスケールの「Vera Rubin NVL72」では毎秒260TBという通信性能を実現した。スイッチには、ネットワーキング内で計算を行う「In-Network Computing」機能に加え、保守性とレジリエンスを向上させる機能が搭載されている。

2:NVIDIA Vera CPU

エージェント型AIの推論向けに設計された、電力効率に優れたCPUだ。88個のNVIDIAカスタム「Olympus」コアを搭載し、「Armv9.2」アーキテクチャとの完全な互換性を備える。「NVLink-C2C」接続による超高速通信で、今日のデータセンターワークロードをサポートするという。

3:NVIDIA Rubin GPU

第3世代の「Transformer Engine」を搭載し、AI推論向けに50 PFLOPS(ペタフロップス)の「NVFP4」コンピューティング性能を提供する。ハードウェアアクセラレーションによるアダプティブ圧縮機能も備えている。

4:第3世代NVIDIA Confidential Computing

Vera Rubin NVL72は、ラックスケールで機密コンピューティングを提供する初のプラットフォームとなる。CPU、GPU、NVLinkのドメイン全体でデータセキュリティを維持し、独自モデルや推論ワークロードを保護する。

5:第2世代RAS(Reliability、Availability、Serviceability)エンジン

GPU、CPU、NVLinkを網羅し、リアルタイムの健全性チェックや耐障害性、予防保守機能を備える。システムの生産性を最大化し、モジュール式のケーブル不要トレイ設計により、Blackwellと比較して最大18倍の速度で組み立てと保守作業を可能にした。

AIネイティブストレージとソフトウェア定義インフラ

Rubinのストレージ基盤として、推論コンテキストを大規模に拡張するためのAIネイティブストレージ「NVIDIA Inference Context Memory Storage Platform」が導入された。

NVIDIA BlueField-4を搭載し、AIインフラ全体でKV(Key-Value)キャッシュデータを効率的に共有、再利用できる他、システムレベルのトラストアーキテクチャ「ASTRA」(Advanced Secure Trusted Resource Architecture)が統合されているという。

「エージェント型AIの応答性とスループット向上に大きく寄与する設計であり、パフォーマンスを犠牲にすることなく、大規模なAI環境を安全にプロビジョニングし、分離・運用できる」(NVIDIA)

次世代イーサネットネットワーキング

データセンターのパフォーマンス向上に向けて、次世代イーサネットの「NVIDIA Spectrum-6」が導入された。200G SerDes(Serializer/Deserializer:シリアライザー/デシリアライザー)通信回路やAI最適化ファブリックによって構築されている。

「Spectrum-X Ethernet Photonics Co-Packaged Optics」スイッチシステムは、従来の方法と比較して稼働時間を5倍に、電力効率を5倍に向上させる。「Spectrum-XGS Ethernet」テクノロジーにより、数百キロ離れた施設を単一のAI環境として機能させることも可能だという。これらの技術により、将来の100万GPU環境への道を開くとしている。

NVIDIA Rubinの提供時期

Rubinプラットフォームは、ワークロードに応じて複数の形態で提供される。

- NVIDIA Vera Rubin NVL72

- 72基のRubin GPU、36基のVera CPU、NVLink 6、ConnectX-9 SuperNIC、BlueField-4 DPUを組み合わせた統合システム

- NVIDIA HGX Rubin NVL8

- x86ベースの生成AIプラットフォームをサポートするサーバボード。8基のRubin GPUをNVLinkで接続

- NVIDIA DGX SuperPOD

- 大規模展開向けのレファレンスアーキテクチャ。Rubinベースのシステムとネットワーキング、管理ソフトウェアを統合

Rubinプラットフォームは既に量産段階に入っており、搭載製品は2026年後半にパートナー企業から提供される予定だ。

2026年にVera Rubinベースのインスタンスを展開するクラウドプロバイダーには、Amazon Web Services(AWS)、Google Cloud、Microsoft、OCI、CoreWeave、Lambda、Nebius、Nscaleが含まれる。Cisco Systems、Dell Technologies、Hewlett Packard Enterprise(HPE)、Lenovo、Supermicroなどのメーカーからも、Rubin製品をベースにした幅広いサーバが提供される見込みだ。

Microsoftは、超大規模データセンター「AIスーパーファクトリー」(関連記事)において、NVIDIA Vera Rubin NVL72ラックスケールシステムを展開する計画だ。

Red Hatは、Rubinプラットフォーム向けに最適化されたAIスタックを、「Red Hat Enterprise Linux」「Red Hat OpenShift」「Red Hat AI」において提供すると発表している。

関連記事

NVIDIA、オープン世界基盤モデルやマルチモーダルRAGなどを発表

NVIDIA、オープン世界基盤モデルやマルチモーダルRAGなどを発表

NVIDIAは、AI活用を促進するための新たなオープンモデルや機能追加を発表した。オープン世界基盤モデルやフィジカルAI、自動運転車開発、ヘルスケア・ライフサイエンス向けの発表内容をまとめる。 NVIDIA、「フィジカルAI」を支援するオープンモデルやフレームワークを発表

NVIDIA、「フィジカルAI」を支援するオープンモデルやフレームワークを発表

NVIDIAはフィジカルAI向けの新たなオープンモデルとフレームワークを発表した。併せて、Boston Dynamicsをはじめとするパートナー企業がこれらを活用した次世代ロボットやロボット運用を効率化している事例も発表された。 GPUリソースを相互再販する「日本GPUアライアンス」 KDDI、さくらインターネット、ハイレゾの3社が設立

GPUリソースを相互再販する「日本GPUアライアンス」 KDDI、さくらインターネット、ハイレゾの3社が設立

KDDI、さくらインターネット、ハイレゾの3社は「日本GPUアライアンス」を設立した。急速に高まるGPU需要に対し、柔軟かつ安定的に高性能GPUリソースを供給する体制の構築を目指す。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.