Facebook最新データセンターの中身:クラウドHot Topics(3)(2/2 ページ)

PUEを1.07にするための工夫とは

PUEは、データセンターへの供給電力を、サーバ機などのIT機器の消費電力で割った数値だ。データセンターに供給された電力が、100%IT機器で活用できるような理想的な環境では、PUEは1となる。しかし現実には、電力がIT機器に到達するまでに、さまざまな変換が行われるために、失われる電力もある。また、IT機器を冷却するための空調システムが消費する電力もある。

PUEを下げる(つまり電力効率を上げる)ための対策としては、まず電力の交流―直流変換の回数を減らすことが考えられる。一般的なデータセンターでは、交流と直流の変換が何度か繰り返され、この過程で発生する電力ロスが、電力の無駄の1要因となっている。

プラインヴィルのデータセンターでは、三相交流480Vをデータセンター内に引き込み、ここから単相交流277Vを取り出してサーバの電源装置で直流に変換する形をとることで、1度だけの交流直流変換に抑え、変換ロスの発生を防いでいる。これを実現するため、Open Compute Projectでは、交流277Vの入力に対応したサーバ用電源ユニットの仕様を公開している。

電力効率にさらに響いてくるのは、データセンターにおける冷却の方法だ。

プラインヴィルのデータセンターでは、まずコールドアイルとホットアイルを明確に分離し、ホットアイルを通路に閉じ込めることを行っている。これを踏まえて、冷却方式に工夫をしている。

このデータセンターでは、外気を最大限に活用し、さらに水の気化熱を使った仕組みを取り入れている。いわゆるチラーの設備は備えていない。データセンターを設置したプラインヴィルの気候は、気化熱による冷却システムに非常に適していると、フェイスブックの仕様書には述べられている。

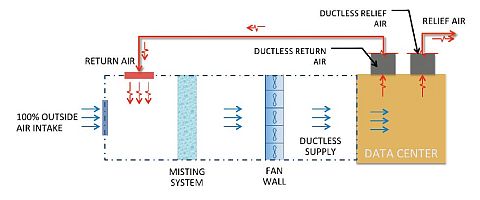

図にあるように、まず外気を取り入れ、気化熱メカニズムによる空気冷却エリアに導き、水のミストを通す。その後、過度な湿気を取り除く。次に送風ファンのエリアに導き、ここからデータセンターのコールドアイルに送り込む。この冷気がコールドアイルからサーバラックを通り、ホットアイルに抜けることで、サーバを冷却する。多くのデータセンターでは、冷気を導くためにデータセンターまでダクトを設置するが、この設計では冷気の送り込み、暖気の排出のいずれについても、ダクトはつくらなくてすむようになっている。外気の取り込みやその冷却は、データセンターの屋根裏的なスペース(フェイスブックではこれを「ペントハウス」と表現している)で行うことで、ダクトの必要性を減らしているという。サーバ冷却後にホットアイルに抜けた暖気は隔離されたまま、天井のファンで外に排出される。

外気の温度が十分低いなら(場合によりデータセンターからの温かい排気を混ぜたうえで)、気化熱メカニズムを作動することなく、そのまま直接データセンターのコールドアイルに送り込む。当然ながら、外気をそのまま使う手法が、電力消費が最も少なく、コストも最小だ。プラインヴィルのデータセンターではこの方法を最大限に活用しているという。

フェイスブックはこうした取り組みをある程度詳しく説明しているが、残念なのは、1.07というPUE値を実現するにあたって、何がどれだけ貢献しているのかが示されていないことだ。

結局真似できる? 真似できない?

これまで紹介してきたフェイスブックのサーバ機およびデータセンターの仕様に見られるアイディアには、既知のものも多い。サーバ機の設計についてはFacebookサービスの運用という明確な用途に基づき、はっきりと割り切っているところが最大の特徴なのかもしれない。そしてカスタム仕様のサーバ機を発注できるだけの運用規模が、この割り切りを支えている。例えばハードウェアレベルでの冗長性が少しでも必要であれば、フェイスブックのサーバ設計は適さない。

データセンターの空調についても、外気を利用するというアイデア自体は新しくない。しかし、これを全面的に導入するという割り切りについては、参考になるのではないだろうか。RackspaceやZyngaも、このプロジェクトに賛同している。

Copyright © ITmedia, Inc. All Rights Reserved.

図5 水の気化熱を利用した冷却システム。ノズルから水が霧状に噴き出している

図5 水の気化熱を利用した冷却システム。ノズルから水が霧状に噴き出している