10分で理解するBusiness Analytics、その全体像(3/3 ページ)

業務系システムにおけるデータの流れを整理する

図1における一連のデータの流れを整理してみましょう。図左上の業務系システムであるCRMや販売管理システムのデータベースから、ETLツールを使って分析用データベースであるDWHにデータを取り込みます。ここからBIツールを使ってレポートを表示したり、データマイニングツールで解析を行います。例えば、特定の顧客に対してメールでのキャンペーンを行う場合なら、データマイニングツールで顧客リストの属性などを使って対象を絞り込み、その結果をCRMに更新します。これが筆者の考える情報系システムの標準的な構成です。以降では、図の構成要素がそれぞれどんな働きをしているのかを1つずつ見ていきましょう。

業務系システム

分析対象データの発生元となる業務系システムのことを指します。実際に情報系システムで必要になるのは、業務ユーザーが入力した業務データが格納されているデータベースです。これを情報系システムに取り込む必要があります。

一般的に、業務系システムは頻繁にデータの更新が行われるため、強く正規化されていてテーブル数が非常に多く、分析には不向きです。リアルタイムにデータを解析する要件がない限り、これらのデータを直接参照することはありません。そこで、分析用には分析専用のデータベース=DWH(後述)を別途、構築します。

これらのシステムのほとんどで有償パッケージソフトウェアが使われています。業務としてこれらを使うエンジニアでない限り、これらのソフトウェアがどのような機能を持つかを知らない方がほとんどでしょう。

数多く存在する業務系システムの1ジャンルに図1に記載したCRMパッケージがあります。CRMは顧客のデータを管理します。顧客との接点となるCRMは顧客一人ずつのプロファイルに迫る必要のある今後のBusiness Analyticsの世界で非常に重要なパッケージです。情報系システムにおける位置づけとしては、CRMから顧客の情報を取り込んでDWHに格納する、あるいはキャンペーンの一環としてメールを送る顧客のプロファイルをデータマイニングして、顧客にフラグを付けてキャンペーンメールを送るというフィードバックの機能も担います。

ただし、CRMからは顧客のデータしか取得できないため、実際には販売管理システムなどから売上データを取得するというように、他のシステムからのデータの取り込みも必要です。図1で挙げているSugarCRMはオープンソースのCRMパッケージです。歴史も長く、無料の範囲内でかなりのことができます。これらのシステムを触った経験がない方は一度インストールして業務系アプリケーションでどのようなことが行われているかを知ってほしいと思います。

ETLツール

ETL(Extract Load Transformation)は、主に業務系システムから情報系システム向けのデータ取り込みや、情報系システム内でのデータの変換に使用するツールです。

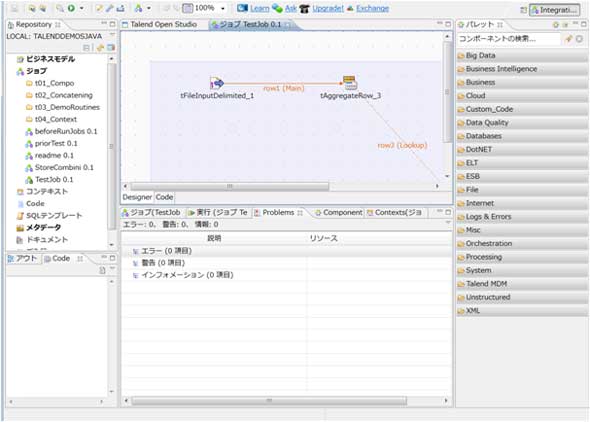

これらのデータ管理は単純なバッチプログラムでも実装可能ですが、企業内のシステム数が増えた昨今では、スケジュール管理や重複データ項目管理を容易にする目的で専用のツールを使用します。特に、データ項目の管理作業はシステムが大規模化すると、煩雑になり運用が難しくなります。このようなツールを用いてビジュアルに管理することでミスや開発工数の削減が可能になり、大規模なシステムでも運用が可能になります。TalendはオープンソースのETLツールの代表例です(図2)。

DWH

情報分析のためのデータベースがDWHです。業務系システムのデータ格納期間が一般的に数カ月単位であるのに対比して、DWHは文字通りデータの倉庫として、過去の古いデータを一定の期間格納し、情報の分析に役立てます。

データの格納手法として、前述したように業務系システムとは異なる特徴を持ち、「スタースキーマ」「非正規化」などの“お作法”に従って格納することでデータ分析の工数削減や、可能な分析を極力幅広く保つことができます(表)。

| 項目 | 業務系 | 情報系 |

|---|---|---|

| 目的 | 業務の遂行 | 情報分析 |

| 構造 | 正規化 | 非正規化/スタースキーマ |

| データ量 | 中 | 大 |

| 主な処理 | 更新 | 参照 |

| 表 業務系データベースと情報系データベースの違い | ||

ただし、実際には、多くの企業でこれらのデータの格納方法を誤っているため、レポーティングシステムに不要な工数を掛けたり、データマイニング過程で担当者が複数のCSVをやりとりし、その整形作業で業務が手いっぱいになる事例が見られます。

逆にいうとDWHの概念をきちんと理解することで、無駄な作業やプログラムの改変作業から解放されます。DWHのDBは、MySQLやPostgreSQLなど、一般的なオープンソースのRDBMSでも十分な性能を発揮するはずです。

BIツール

よく整備されたデータベースがあれば、それを集計してレポートにするだけで、高度な統計的素養を持ったアナリストの解析結果を上回ることも不可能ではありません。そして、これを現場のユーザーが参照して日々の業務改善に生かす仕組みを作ることができれば、多くの企業が成績を向上できるはずです。BIツールはDWHをデータ参照先として想定して作成されたレポーティングツールで、多くの場合、Webアプリケーションとして実装されます。

データ解析作業では、集計軸の変更や特定データの除去といった作業が頻繁に発生します。そのたびにレポーティングツールの画面仕様を変更したり、SQLクエリを書き換える作業は煩雑であるため、BIツールによる作業支援が必要になります。図1で示したPentahoやJasperSoftはオープンソースBIツールの代表格です。

データマイニングツール

データマイニングは今後のBusiness Analyticsをけん引役となる技術です。データマイニングツールが活用できるようになると、前述したような商品レコメンデーションや顧客クラスタリング、売上予測モデルの構築、テキストマイニングなど、従来できなかった観点からの分析が、高い精度で簡単に行えるようになります。

データマイニング作業の9割は「データの成形と下準備」といわれます。データマイニングを実施するには、ツールに入力するためのデータをファイルとして用意する必要があるからです。DWHを構築済みの場合はデータマイニング用のデータをSQL一文で簡単に用意できます。つまり、きれいなデータベースを構築しておけば、9割の作業を削減できるわけです。データ解析担当者は、統計モデリングのようなより複雑な作業に専念できます。このような点においてITエンジニアのスキルはデータマイニング作業において必要とされるでしょう。

図1で挙げているRはオープンソースのプログラミング言語で統計開発に特化した関数を多く持っているのが特徴です。現在では、データマイニングのデファクトスタンダードになりつつあります。学術系での利用実績が多く、最新アルゴリズムが簡単に実装でき、カスタマイズ性が高いので、統計情報を簡単に多様なグラフ図に描画できます。Rは他の商用統計ソフトに比べて遜色ないシェアを有しています(注2)。

以上が、筆者が考える情報系システムの構成と各要素の概要です。図1は至ってシンプルな構成図ですが、筆者が知る限り、実際にはこれら全てをきれいな形で実装している企業は少ないのが現状です。次回以降は、ここに示した各要素の詳細を解説していく予定です。

参考1:トーマス・H・ダベンポート、ジェーン・G・ハリス著(村井章子訳)『分析力を武器とする企業 強さを支える新しい戦略の科学』(日経BP)

筆者紹介

日本GMAP 中川帝人

日本GMAPにおいて地理情報を生かした統計解析等、企業のデータ解析、活用の啓蒙を行う。ソフトウェアベンダでBIのコンサルタントを経験後、2012年より現職。

- 日本GMAPのホームページ:http://www.gmap-j.com/

- メールアドレス:teito.nakagawa[at]gmap-j.com

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ

Talend

Talend