AIとは何か、人工知能学会会長が語った常識と誤解:ディープラーニングは万能ではない

人工知能(AI)がブームになっているが、これまでのブームとどう違うのか。AIは、どのような発展段階にあるのか。人間の仕事を奪う「敵」なのか。人工知能学会会長である山田誠二氏の、こうした疑問に答えるような講演を要約してお届けする。

人工知能(AI)がブームになっているが、これまでとどう異なるのか。人工知能は、どのような発展段階にあるのか。人間の仕事を奪う「敵」なのか。こうした疑問に答えるような講演を、人工知能学会会長の山田誠二氏が、2016年11月1日に開催したイベント「SAS Analytics Next 2016」で行った。これを要約してお届けする。山田氏は国立情報学研究所教授、総合研究大学院大学複合科学研究科情報学専攻教授、東京工業大学情報理工学院情報工学系特定教授を務めている。

なお、以下は山田氏の講演を要約・再構成したものであり、文責は筆者にある。

「強いAI」と「弱いAI」

何を「人工知能」と呼ぶかについて、学者の間で意見が統一されているわけではない。基本的には、「(人間並みの)知的な処理をコンピュータ上に実現すること」だといえる。考え方は、「強いAI(Strong AI)」と「弱いAI(Weak AI)」に分かれている。強いAIは人間と同等の知能を目指し、弱いAIはあくまでも人間を支える知能を目指している。歴史的には、強いAIから弱いAIへと関心が移ってきた。一方最近では「シンギュラリティ」という言葉に象徴されるように、一部で強いAIを指向する動きもみられる。

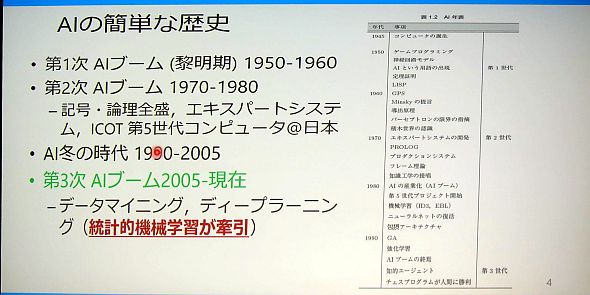

現在は、第3次人工知能ブームだといえる。第1次ブームは黎明期の1950〜60年ごろ、第2次ブームは1970〜80年ごろで、その後冬の時代があった。

第2次ブームは、人間の知識を「if then else」のロジックで表現し、三段論法でこれをつなげていくことにより、人間のやっている推論は再現できるという前提に立っていた。その応用例がエキスパートシステムで、限定的な成果を収めた。

エキスパートシステムの限界は、「人間は自分の知っている以上のことを知っている」ということにあった。必ずしも意識していない知識や経験が、人の判断に影響を与える。第2世代のAIは、これに対応できなかった。

2005年ごろからの第3次ブームの第1次、第2次との大きな違いは、統計的機械学習のアルゴリズムが活発に開発されて応用が進んだこと、そしてディープラーニングによりニューラルネットワークが復権したことにある。ただし、第1次、第2次で指摘されてきた問題は、根本的には一部しか解決していない。

ディープラーニングは万能ではない

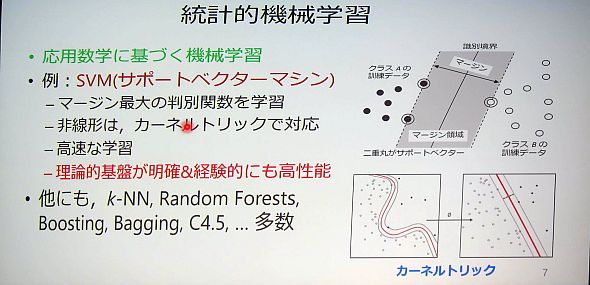

統計的機械学習にはさまざまな手法があるが、最も使われているのが「教師あり分類学習」。これは例えば、「犬か猫か」の判別をするために、「犬」「猫」のラベルをつけた大量のデータを機械学習アルゴリズムに入力すると、犬か猫かの境界を線引きする関数が自動的に生成される。このため人間がルールを書く必要がなくなる。ただし、逆に機械が生成した関数を人間が見ても理解できない。統計なので、データが多いほど精度が上がる。

統計的機械学習の典型的なアルゴリズムに、「サポートベクターマシン(SVM)」がある。線引きをする際に、垂直二等分線を使うというもので、理論的な裏付けがあり、高速に計算する方法も分かっている。理論的な裏付けが明確であるため、「こういうタイプのデータに対しては有効に働くだろう」という見込みを立てやすい、高速に計算ができるため、応用がしやすい。統計的機械学習は、他にも数百のアルゴリズムがある。

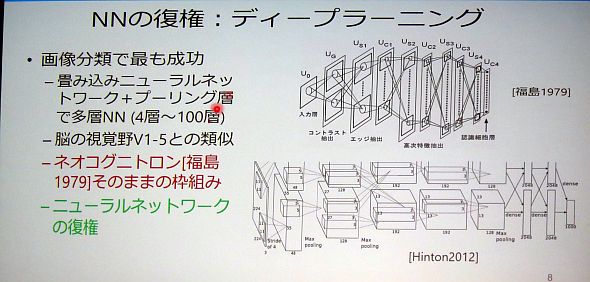

ディープラーニングは、1979年に福島邦彦氏が論文で発表したニューラルネットワーク理論のネオコグニトロンをそのまま使っていると言っていい。当時に比べて大量なデータが比較的安価に入手できるようになる一方、コンピュータパワーが向上したため、応用が進んできた。

ディープラーニングはさまざまな適用の成功例がある。一般物体認識に始まり、テレビゲームの学習、グーグルの猫、そしてAlphaGoが広く知られている。ただし、AlphaGoは大枠としてはモンテカルロ法であり、一部にディープラーニングを利用している。

だが、ディープラーニングは万能ではない。

まず、パラメータの数が非常に多い。百数十層になってくると、パラメータの数は億単位。人がチューニングを実施するが、人に伝承できない「黒魔術」的な作業になる。

また、訓練データが膨大に必要で、このため適用できない分野がある。

統計的機械学習とは対照的に、理論的な基盤が弱いという側面もある。日本のニューラルネットワークの人たちは理論的な指向があるため、あまりディープラーニングに取り組まない。「やってみて駄目かもしれない」というものであるため、適用分野選定のノウハウも蓄積されない。

AIの得意な分野と不得意な分野、有望な応用分野

上記のようなAIは、コンピュータプログラムなので、得意・不得意がある。

AIが得意なのは、静的データと閉じた空間だ。静的データとは、全体的な傾向が固定しているようなデータを意味する。静止画像、ゲーム、試験問題などがこれに当たる。AlphaGoなどのゲームは、探索空間こそ非常に広いとしても、ルールで決められている空間であるため、コンピュータで処理しやすい。

もう1つは閉じた空間。人間は、「あのドアから次に誰が入ってくるのかを100%予測できない」という「Open World」にいる。AIはそういう世界は苦手。予測できないことが起こった時に対処するのが不得意だ。

AIが苦手とするのは、得意な分野の裏返しで、動画の処理や、一般的な問題解決などだ。また、「物を持って離せば下に落ちる」といった常識的な推論ができない。

物理的な世界も不得意。ロボットは発達してきたものの、まだまだ十分ではない。例えばテレビ番組で紹介していた「アマゾンピッキングチャレンジ」は、棚から物を出して箱に入れるという作業を複数チームが競う大会で、この作業自体は人間なら子供でもできる。だがロボットでは「物をどう認識するか」「どう掴めば傷付けずに済むか」という戦略の計算に長い時間がかかり、さらにどのチームも完全には成功しない。

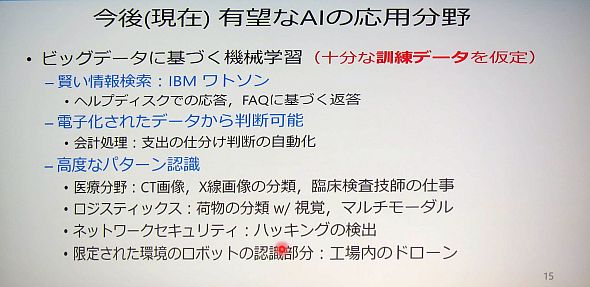

有望な応用分野には、IBM Watsonが得意としている「賢い情報検索」や、会計処理の高度化などがある。また、パターン認識も有望で、医療画像処理、貨物の仕分け、ネットワークセキュリティなどに、今後も生かせる可能性がある。

「AIは人間の仕事を奪う」? 日本企業は何をすべきか

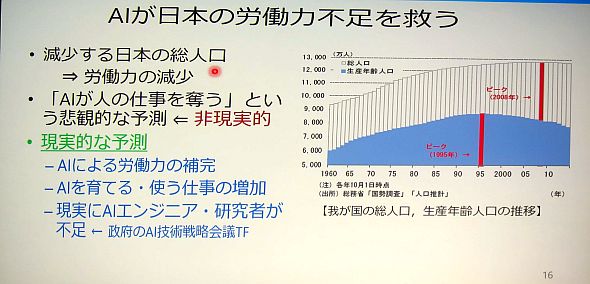

日本では労働力が減少を続けている。これをロボットで補うことは、職種によっては可能だと考える。よく「AIは人の仕事を奪う」という悲観的な予測がなされている。だが、AIが一部人間の仕事を代行することで、AIを使ったり、メンテナンスしたりする仕事が生まれる。研究者の間では全体として仕事がむしろ増えるのではないかと考えられている。特にAIエンジニアは不足している。

労働は再定義されるだろう。つまり、人間がやる必要のない仕事がはっきりしてくる。AIにできる仕事は、基本的には人間がやらなくていい仕事だといえる。

では、今後AIはどのように進むべきか。参考にできるのはアドバンスド・チェスだ。1997年に、チェスの名人であるガルリ・カスパロフがIBMのコンピュータ「Deep Blue」に負けた。この時、「コンピュータに負けるのなら、人間はチェスをやらなくなるのではないか」といわれた。

だが、そうはならなかった。カスパロフは、人間とコンピュータがチームとなって対戦するルールを作った。これが非常に象徴的といえる。

すでに「インタラクティブAI」として実用化されつつあるが、例えば飛行機の操縦で、ロボットが副機長となる。また、「Baxter」というロボットは、手を取って人間が教えると、作業を学習し、人間をサポートできるようになる。こういう関係が今後広がっていくし、人とコンピュータのあるべき姿だと考えている。

研究者の目で見て、日本の企業に求められることは何か。企業で基礎研究は大変なので、応用を徹底的に進めていってほしい。

実践的な応用の範囲は、理論的なものとはずれることが多い。こうしたところから、応用における課題が基礎研究にフィードバックされ、基礎研究を活性化することがあり得る。

企業が準備すべきことは、適切にAIを理解し、限界を知ることだ。現在は、過大評価されている部分もかなりある。これを冷静に理解し、受け入れる体制を整えてほしい。最終的には人間が判断を下すことをベースに考えれば、導入がしやすいと思う。

大学や公的研究機関とのコラボレーションは、AIへの近道といえる。基礎研究者の中には、実応用をしてもらえる例を探している人たちがたくさんいる。人工知能学会でも、マッチメーキングの場を提供しようとしている。大企業とスタートアップ企業とのコラボレーションも、最近は増えている。

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ

人工知能学会会長の山田誠二氏

人工知能学会会長の山田誠二氏