グッドハートの法則(Goodhart's Law)とは?:AI・機械学習の用語辞典

「指標が目標になると、それは“良い指標”ではなくなる」という逆説的な法則のこと。もともとは経済政策の現場で知られてきたが、教育評価や業績管理など、目標を数値化する場面でも応用されることが多い。AIや機械学習の文脈でも、評価指標に関する議論などで言及されることがある。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

用語解説

グッドハートの法則(Goodhart's law)とは、「ある指標が目標になると、その時点でその指標は“良い指標”ではなくなる」(When a measure becomes a target, it ceases to be a good measure.)という法則である。もともとは、イギリスの経済学者チャールズ・グッドハート(Charles Goodhart)氏が1975年に発表した、経済政策に関する論文の中で提示された原則だが、近年では経済、教育、評価、AI/機械学習など、さまざまな分野で広く応用されている。

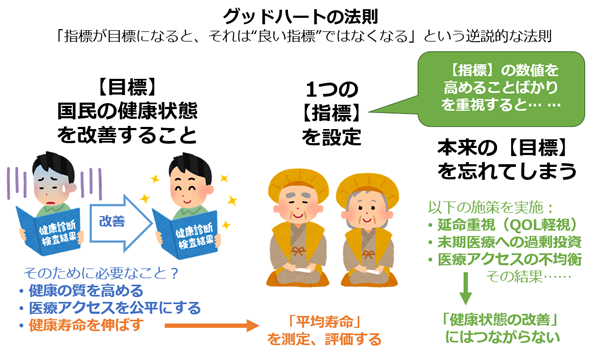

例えば「国民の健康状態を改善する」という政策目標に対して、「平均寿命」を唯一の指標として設定したとしよう。この場合、平均寿命を延ばすことばかりが重視されるようになり、本来の目標そのものが見失われてしまう恐れがある。具体的には、「延命」が最優先されるようになり、「生活の質(QOL)を無視した医療の継続」や「末期医療」などに偏った政策と投資ばかりが重点的に実施される事態を招く可能性がある。これは、「国民の健康状態を改善する」という本来の目標から大きくかけ離れた内容である。

本来目指すべきは、「健康の質の向上」や「社会階層を問わない平等な医療アクセスの実現」なども含めた、より包括的な健康の改善であるはずだ。しかし、「平均寿命」という指標がいつの間にか目標へと置き換えられてしまうことで、その指標はもはや目的達成のための手段として機能しなくなる。グッドハートの法則が示すように、ある指標が目標に置き換わった時点で、その指標はその本来の意味を失ってしまうのである(図1)。

冒頭でも示した通り、グッドハートの法則が適用される問題は、経済政策にとどまらず、教育評価や業績管理など、目標の可視化や数値化が求められる幅広い分野でしばしば生じる。「数値で示せる目標」は管理しやすく現場で採用されやすい一方で、その指標ばかりが重視されるようになると、本来の目的が置き去りにされ、形だけの成果に終わってしまうことも少なくない。だからこそ、この法則は常に意識しておきたい原則である。

AI/機械学習の分野においても、グッドハートの法則は見過ごせない問題である。例えば、正解率(Accuracy:正確さ)やF1スコア、AUCといった機械学習モデルの評価指標ばかりが重視されるあまり、本来のビジネス上の目標が置き去りにされてしまう場面がある。

ここで、スパムメールを検出する分類モデルを考えてみよう。本来の目標は、「ユーザーにとって不要または有害なメールをブロックし、必要なメールは確実に届けること」である。しかし、モデルの指標として正解率ばかりが重視されると、問題が生じる可能性がある。

例えば、全体の大多数(例:99%)がスパムで占められている場合、全て(例:100%)のメールを「スパム」と判定するだけでも正解率は高く(例:99%に)なる。形式上は「高い正解率」と評価されるが、実際には必要なメールまでブロックされ、ユーザー体験を損ねることになる。つまり、指標が最適化されても、ユーザー体験やビジネスの成果は悪化しているというわけだ。

グッドハートの法則に従うなら、これは指標が目標にすり替わったケースであり、正解率はもはや“良い指標”ではなくなっている。そのため、結果として目標も達成できなくなっている。

このようなケースでは、正解率だけでなく、「スパムだと判定したメールのうち、実際にスパムだった割合」を示す適合率(Precision)や、「実際に存在するスパムメールのうち、正しくスパムと判定できた割合」を示す再現率(Recall)に加え、「実際にはスパムでないメールのうち、誤ってスパムと判定されなかった割合」を示す特異度(Specificity)などの指標も併せて評価する必要がある。複数の観点からモデルを分析することで、初めて本来の目標との整合性を保った評価が可能になるからだ。

本来の目的を見失わないためにも、「指標はあくまで手段である」という視点を持ち続けることが、AIや機械学習の実装においても重要である。

Copyright© Digital Advantage Corp. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ