人工筋肉やVR/AR、仮想ロボット、FoodTech……、先端技術から生まれるプロダクトとは:Microsoft Innovation Award 2017最終選考会(2/5 ページ)

好きなキャラクターと暮らせるバーチャルホームロボット「Gatebox」:「オーディエンス賞」「PR TIMES賞」

Innovation Day会場の参加者が投票して決定した「オーディエンス賞」とスポンサー賞の1つ「PR TIMES賞」を受賞したのは、好きなキャラクターと自宅で一緒に暮らす生活を体験できるバーチャルホームロボット「Gatebox」だ。ウィンクルが提供に向けて開発している。

Gateboxは、小型のテーブルの上に置くことができるサイズの筺体の中に、ユーザーが好きなデジタルキャラクターの3D映像を投影させ、音声でリアルタイムにコミュニケーションを行えるプロダクトだ。筺体には、マイクとカメラの他、LEDやセンサーを制御するマイクロコンピュータ(マイコン)を備えている。

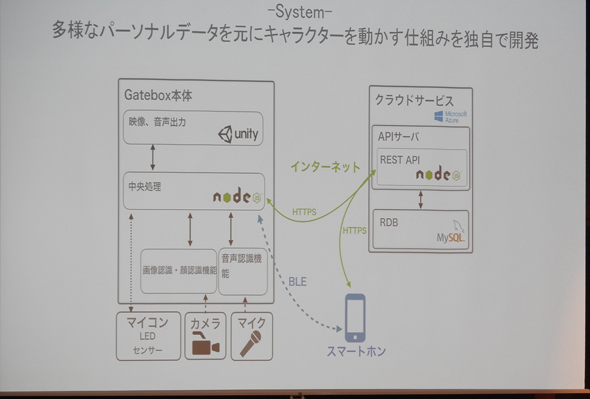

ソフトウェアについては、多様なパーソナルデータを基にキャラクターを動かす仕組みを独自に開発。node.jsによって音声認識や画像認識、顔認証などを処理し、Unityで画像や音声の出力をしている。クラウド側では、AzureのWeb Appsを活用して開発・運用の効率化を図っている。

世界には既にさまざま音声アシスタントサービスが存在しているが、そのほとんどが無機質で人間味に欠けている。ウィンクルは、好きなキャラクターをユーザーインタフェースに採用することで、日本ならではの表現力によって、ユーザーがコミュニケーションをとったり、一緒に暮らしたりしたくなるバーチャルロボットの実現を目指す。

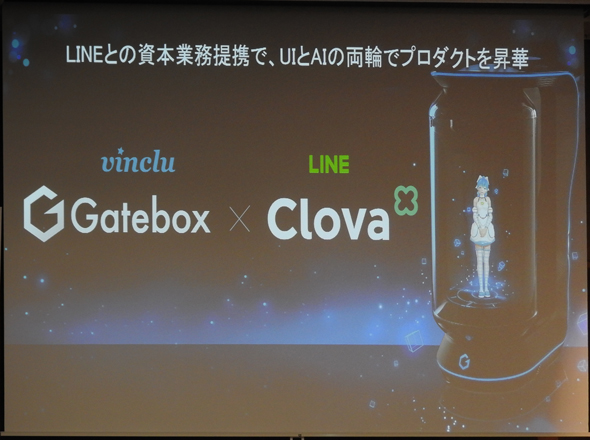

2016年12月14日には予約限定販売を開始、初日で100台、1カ月で予定の300台を完売した。2017年3月にはLINEとの資本業務提携を締結し、LINEのクラウドAIプラットフォーム「Clova」との連携を図る。今後は、VRやAR、モノのインターネット(IoT)、人工知能(AI)などの技術を駆使して、好きなキャラクターと現実世界でよりリアルに暮らせる世界を実現したいとしている。

ネットで簡単にオリジナル調味料を作成できる「マイソースファクトリー」:「Samurai Incubate賞」

スポンサー賞「Samurai Incubate賞」を受賞したのは、オルターブースが開発したインターネットを活用して簡単にオリジナル調味料を作成でき、健康な食を提案するFoodTechサービス「マイソースファクトリー」だ。

健康寿命を伸ばすことが社会的な課題になってきている今、テクノロジーを駆使して「食」を改善する「FoodTech」に注目が集まっているという。オルターブースは、マイソースファクトリーのサービスを、健康寿命延長をサポートするFoodTechと位置付けている。

マイソースファクトリーは、「ベースソース」(ポン酢、ドレシング、焼肉のタレなどの身近な調味料)の「パラメーター」(甘味や辛味、風味、果汁など)を調整し、「甘みが強い」「辛味が強い」といった自分好みの味感覚でオリジナルのソースを作成できるサービス。オリジナルソースは1本から注文でき、商品は工場から直送される。また作ったオリジナルソースのレシピやパラメーターは、SNSでシェアすることができ、「世界で1つだけのマイソース」として公開することが可能だ。

このサービスで注目なのは、「パラメーターをどのように調整しても、おいしいソースに仕上がるように、あらかじめベースソースが調整されている」ことだ。利用者は安心してソース作りを楽しむことができる。

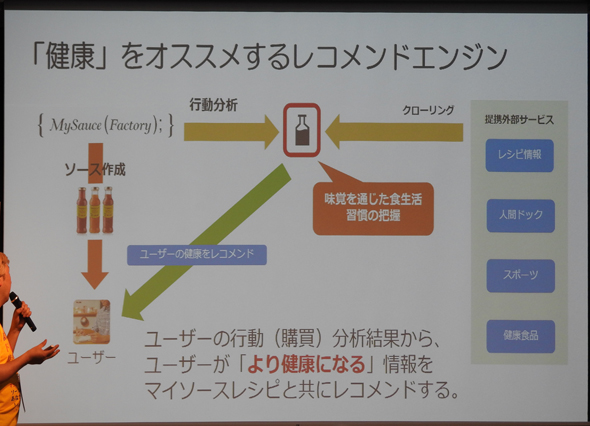

今後オルターブースは、健康なソース作りを提案するレコメンドエンジンを使ったサービスを提供する予定だ。これはユーザーの購買行動を学習して分析し、ユーザーがより健康になる情報をマイソースレシピとともにレコメンドするというものだ。例えば、ユーザーが塩分濃度の高いパラメーターを選択している場合、このレコメンドサービスが血圧といった健康に配慮したパラメーターのソースを提案する。オルターブースは外部サービスとの連携により、健康情報を付加して提案する機能の追加も計画している。

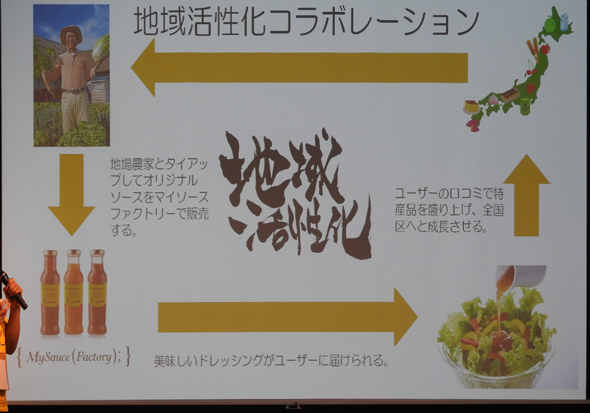

もう1つ注目なのは、マイソースファクトリーをプラットフォームとして活用することで地域活性化のコラボレーションを実現できることだ。例えば、オルターブースは地場の農家とタイアップして、マイソースファクトリーでオリジナルソースを販売することを計画している。これにより農家は、本来破棄される一般市場に提供できない規格外の農産物を使っておいしいソースを作成し、全国のユーザーに提供することができる。

自分の分身のように遠隔操作できる人型ロボット「GITAI」:「SLUSH Tokyo賞」「Tech in Asia賞」

「SLUSH Tokyo賞」「Tech in Asia賞」の2つのスポンサー賞を受賞したのは、テレイグジスタンスを実現する人型テレプレゼンスロボット「GITAI」である。開発は、MacroSpaceがフルスクラッチで取り組んでいる。

GITAIは、人間の視覚や触覚をインターネット経由で同期することで、自分の分身のように遠隔操作できる人型テレプレゼンスロボット。操作者がVRゴーグル「Oculus Rift」を装着して画面で操作するか実際に体を動かすと、遠隔地のロボットも同期してリアルタイムに動作する。そのため、操作者はロボットに乗り移ったかのような感覚でロボットを操作できる。

操作者は、VR端末でパネルを操作したり、歩いたりすることでロボットを動かすことができる。操作者が歩いてロボットを動かす場合、動作がリアルタイムに同期するようになっている。またGITAIは、ロボットが触った感触を操作者に伝える仕組みも実現している。具体的には、ロボットの手に取り付けている触覚センサーがモノを触ったときのさわり心地を認識し、操作者が身に付けた触覚センサーの付いたグローブに伝えるのだ。

GITAIは、ハードウェアとしての人型ロボットと、インターネットを介して人間とロボットの動きを同期させるソフトウェアで構成されている。MacroSpaceは、ロボットも含め、この2つの要素の全てをフルスクラッチで作っている。その理由は、インターネット回線を経由して人間とロボットの動きを同期するリアルタイム性を確保するためだ。もし同期するのに数秒かかってしまうと、操作者がロボットの動きを自分の動きとして認識できなくなってしまう。

ではこのリアルタイム性をどのように実現しているだろうか。GITAIは、同期の通信にUser Datagram Protocol(UDP)を使用している。だがUDPを使って、VR越しに見える360度画面を表示するために大量データを送信すると、どうしてもパケットロスが生じてしまう。そこで、GITAIは人間が感知できないパケットロスを原則的に無視し、例外的に人間が感知できるようなパケットロスや遅延を機械学習で予測、補完することで、リアルタイム性を確保している。

またGITAIは、目の動きを認識するVRヘッドマウントディスプレイ「FOVE」に代表するアイトラッキング技術を使って、視点中心点以外の360度動画の解像度を段階的に下げることでデータ通信量を削減する取り組みもしている。

関連記事

VR、人工知能、画像/音声/動画解析、IoTの最先端16事例が披露されたMicrosoft Innovation Day 2016

VR、人工知能、画像/音声/動画解析、IoTの最先端16事例が披露されたMicrosoft Innovation Day 2016

Microsoft Innovation Day 2016では、先進的な技術やサービスを提供する企業やスタートアップを表彰するInnovation Award 2016のファイナルピッチと表彰式が行われ、日本のスタートアップの最新の取り組みが明らかになった。本稿ではファイナリストたちが発表した優れたアイデアや最先端のサービスの一端をお届けする。 みずほフィナンシャルグループがAPIを中心に展開するFinTech最新事例――Amazon Echo、Soracom、LINE、Facebook、マネーフォワード、freee

みずほフィナンシャルグループがAPIを中心に展開するFinTech最新事例――Amazon Echo、Soracom、LINE、Facebook、マネーフォワード、freee

みずほフィナンシャルグループは、FinTechビジネスの立ち上げに本腰を入れて取り組んでおり、そこで重要なカギを握っているのが金融APIだという。では、どのようなAPIエコシステムを形成しようとしているのか。「API Meetup Tokyo #17」の講演模様からまとめてお伝えしよう。 マッシュアップもIoTへ――「下手な芸人より面白い」「狂気を感じる」「絶句した」な12作品が集まった #MA11 決勝戦まとめ

マッシュアップもIoTへ――「下手な芸人より面白い」「狂気を感じる」「絶句した」な12作品が集まった #MA11 決勝戦まとめ

全国の開発者が、自らの技術力と、世の中に公開されているさまざまなAPI、ハードウエア、センサーなどを「マッシュアップ」して、新たな作品を作り出すコンテスト「Mashup Awards」(MA)が今年も開催。同コンテストの最優秀作を決定する最終プレゼンテーション「ファイナルステージ」と、各賞の発表が、11月18日に東京の渋谷ヒカリエで行われた。

Copyright © ITmedia, Inc. All Rights Reserved.

筺体の中に好みのキャラクターの3D映像を投影

筺体の中に好みのキャラクターの3D映像を投影 多様なパーソナルデータを基にキャラクターを動かす仕組みを独自開発

多様なパーソナルデータを基にキャラクターを動かす仕組みを独自開発 LINEとの資本業務提携でUIとAIの両輪でプロダクトを昇華

LINEとの資本業務提携でUIとAIの両輪でプロダクトを昇華 作成するソースの元になる主なベースソース

作成するソースの元になる主なベースソース 「健康」をオススメするレコメンドエンジン

「健康」をオススメするレコメンドエンジン 地域活性化コラボレーション

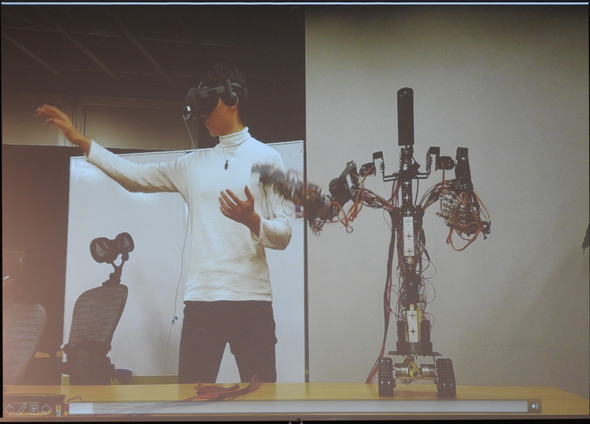

地域活性化コラボレーション GITAIのプロトタイプ3号機

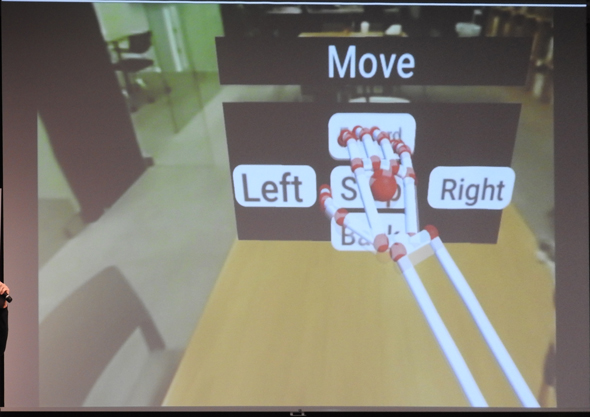

GITAIのプロトタイプ3号機 VRゴーグルを着けた操作者から見た様子

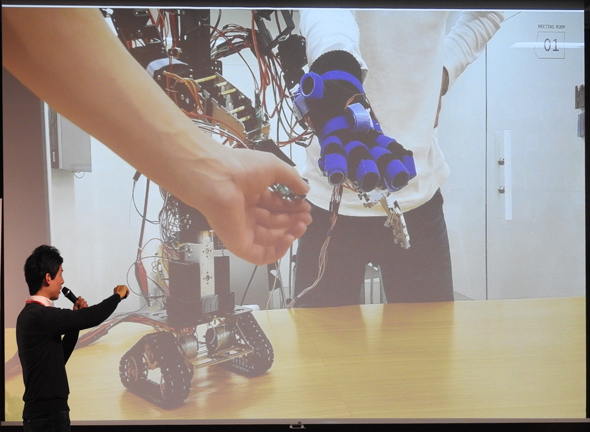

VRゴーグルを着けた操作者から見た様子 触覚グローブでロボットの手の感覚を操作者の手に伝達

触覚グローブでロボットの手の感覚を操作者の手に伝達