高性能なディープニューラルネットのフレームワークを開発、ノースカロライナ州立大:視覚認識の性能が向上

ノースカロライナ州立大学の研究チームが、ディープニューラルネットワーク(DNN)を構築するための新しいフレームワークを開発した。標準的なベンチマークテストで性能を検証したところ、視覚認識の性能がこれまでのフレームワークを上回った。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

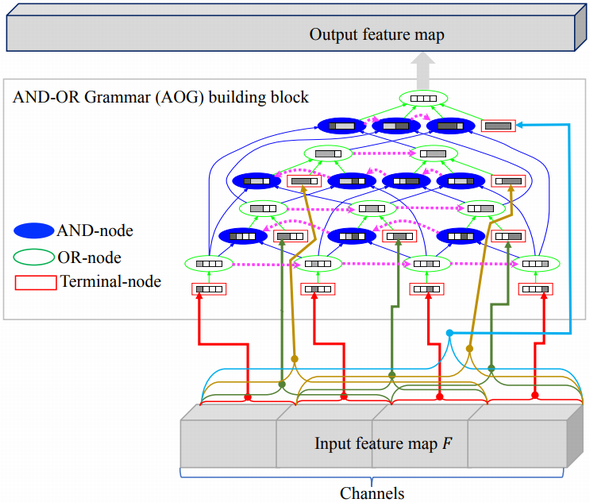

ノースカロライナ州立大学の研究チームが、多層のニューラルネットワークからなるディープニューラルネットワーク(DNN)を構築するための新しいフレームワークを開発した。文法に基づくネットワーク(grammar-guided network)ジェネレーターを使用するものだ。

新しいフレームワークで構築したDNN「AOGNet(And-Or Grammar Network)」は、視覚認識タスクの実験テストにおいて、既存の最先端のフレームワーク、例えば広く使われている「ResNet」や「DenseNet」などで構築したネットワークを上回るパフォーマンスを発揮した。

ノースカロライナ州立大学電気コンピュータ工学部で助教授を務めるティアンフ・ウー氏は、研究チームの中心メンバーの一人だ。同氏は次のように述べている。「AOGNetは、われわれがテストしたどのネットワークよりも予測精度が高い。さらに解釈可能性が高いため、ユーザーはシステムがどのように結論に到達するか確認できる」

新フレームワークは、システムアーキテクチャに関する構成的文法のアプローチを採用しており、従来のネットワークシステムのベストプラクティスを利用して、生データから有用な情報を効果的に抽出する。

「階層型で構成的な文法が、従来のシステムアーキテクチャのアプローチを統合する、シンプルで洗練された方法を提供することが分かった。これは、われわれの知る限りでは、文法をネットワーク生成に利用する初めての取り組みだ」(ウー氏)

高いベンチマーク性能を示した

新しいフレームワークをテストするために、研究チームはAOGNetを開発した。その上で3種類の画像分類ベンチマークテスト「CIFAR-10」「CIFAR-100」「ImageNet-1K」を使って性能を確認した。

「AOGNetは、ResNetやDenseNet、ResNeXt、DualPathNetといった最先端のネットワークのどれよりも大幅に高いパフォーマンスを実現できた。ImageNetのネットワーク分析指標を使ったモデルの解釈可能性のスコアも、一番良かった」(ウー氏)

研究チームはその後、「Microsoft COCO」ベンチマークと「Mask R-CNN」のバニラシステムを使って、AOGNetのオブジェクト検知やインスタンスの意味の分類について、AOGNetのパフォーマンスをテストした。

「AOGNetは、ResNetやResNeXtのバックボーンよりも良い結果を出した。AOGNetのモデルサイズは小さく、推論時間は同等か、若干短かった。こうした結果は、オブジェクト検知や分類におけるAOGNetの学習効果の高さを示している」(ウー氏)

これらのテストは現実の課題に直結する。画像分類は、視覚認識の基本的タスクの一つであり、ImageNetは大規模分類ベンチマークの標準だ。同様に、オブジェクト検知や分類は、高度な視覚タスクの主要なものであり、Microsoft COCOは、最も広く使われているベンチマークの一つだからだ。

「AOGNetは、原理に基づく文法フレームワークの下で開発されている。AOGNetがImageNetとMicrosoft COCOで、これまでのネットワークを大幅に上回る結果を記録したことは、表現学習がさまざまな実際のアプリケーションに、幅広く、深い影響を与える可能性を示している」(ウー氏)

研究チームは、研究成果をまとめた論文「AOGNets: Compositional Grammatical Architectures for Deep Learning」を、2019年6月16〜20日に開催されるIEEE Computer Vision and Pattern Recognition Conferenceで発表する。

関連記事

Intel、AI開発者向けの小型デバイス「Intel Neural Compute Stick 2」を発表

Intel、AI開発者向けの小型デバイス「Intel Neural Compute Stick 2」を発表

Intelは、スマートAIアルゴリズムの作成や、ネットワークエッジでのコンピュータビジョンのプロトタイピングに対応できるUSBスティック型のハードウェア「Intel Neural Compute Stick 2」(Intel NCS 2)を発表した。 Gartner、2018〜2023年の戦略的IoTテクノロジートレンドのトップ10を発表

Gartner、2018〜2023年の戦略的IoTテクノロジートレンドのトップ10を発表

Gartnerは、「2018〜2023年にデジタルビジネスイノベーションをけん引する」と認定した戦略的IoTテクノロジートレンドのトップ10を発表した。 Intel、Xeon上での「TensorFlow」使用時向けにDNNモデルコンパイラ「nGraph」の性能を強化

Intel、Xeon上での「TensorFlow」使用時向けにDNNモデルコンパイラ「nGraph」の性能を強化

Intelは、「Intel Xeonスケーラブルプロセッサー」上で「TensorFlow」を使用するデータサイエンティスト向けに、フレームワーク非依存のディープニューラルネットワークモデルコンパイラ「nGraph Compiler」のパフォーマンスを高めるブリッジコードを提供開始した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.