生成AIリスク探索のオープンフレー厶ワーク「PyRIT」、Microsoftがリリース:生成AIのセキュリティと責任あるAIのリスクを探る

Microsoftは生成AIのリスクを探索する自動化フレームワークPyRIT(生成AIのためのPythonリスク識別ツールキット)の導入を発表した。生成AIパラダイムにおけるレッドチーム特有の課題に対処する。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

Microsoftは2024年2月22日(米国時間)、セキュリティ専門家と機械学習エンジニアが生成AIシステムのリスクを発見するためのオープンな自動化フレームワーク「PyRIT」(Python Risk Identification Toolkit for Generative AI)をリリースした。

PyRITを開発した背景には、MicrosoftがAIシステムのセキュリティを評価し、改善することを目的に運営する「AI Red Team」の存在がある。このチームは、セキュリティ、敵対的機械学習、責任あるAIといった分野の専門家で構成され、Microsoft全体のリソースを活用している。

Microsoftは、顧客にリリースする前に幾つかの生成AIシステムとモデルのリスクをレッドチーム(※)で積極的に評価していた。それを通じて、生成AIのレッドチームが、古典的なAIシステムや従来のソフトウェアのレッドチームと3つの点で大きく異なることを発見したという。

(※)システムなどに攻撃や侵入を試みることで、セキュリティ対策の有効性を判断したり、脆弱(ぜいじゃく)性を明らかにしたりするチームのこと

AIレッドチームにおける自動化の必要性

1.セキュリティと責任あるAIのリスクを同時に探る

従来のソフトウェアや古典的なAIシステムのレッドチームは、主にセキュリティ上の不具合を特定することに重点を置いてきた。生成AIシステムのレッドチームには、セキュリティリスクだけでなく、責任あるAIに関するリスク(公平性に問題のあるものや根拠がないもの、不正確なコンテンツの生成など)の特定も含まれる。AIを扱うレッドチームは、セキュリティと責任あるAIに関する潜在的なリスク空間を同時に探索する必要がある。

2.不確実性、変動性に対処するレッドチー厶へ

生成AIシステムのレッドチー厶は、従来のレッドチー厶よりも不確実性の度合いが高い。従来のソフトウェアシステムにおけるレッドチームでは、同じ攻撃経路を複数回実行した場合、ほぼ同じ結果になる可能性が高いが、生成AIシステムは複数の非決定層を導入しており、同じ入力が異なる出力につながる。そのため、生成AIに対する攻撃の正確な結果を予測したり再現したりするには、その機能における固有のランダム性と変動性を考慮した戦略が必要となる。

3.生成AIシステムのアーキテクチャは多種多様

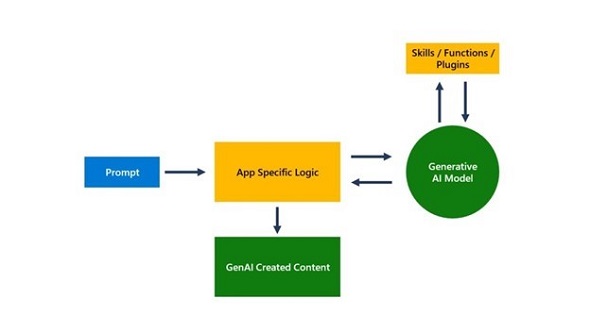

生成AIシステムは、スタンドアロンのアプリケーションから既存のアプリケーションへの統合まで、多様なアーキテクチャを示し、テキスト、音声、画像、動画など、さまざまな入出力様式を伴う。

レッドチームが手作業でプロービングしようとすると、上記の3つの違いがそれぞれ脅威となってのしかかる。 アプリケーションのそれぞれのモダリティにおいて、1つのタイプのリスクを表面化させるためだけでも、異なる戦略を何度も試す必要がある。 全てのタイプの危害やモダリティについて、手作業でこれを行うのは、非常に煩雑で時間がかかる。

だからといって、全てを自動化すればいいというわけではない。自動化はスケーラビリティのために不可欠だが、手作業によるプロービングは潜在的な盲点を発見するために依然として重要だ。

こうした課題に対応するため、Microsoftは機械学習用のレッドチーム自動化フレームワークに代わるツールキットであるPyRITを作成した。このツールキットでは、包括的なセキュリティ評価のための手動プロービングと自動化の組み合わせに重点を置きながら、生成AIパラダイムにおけるレッドチーム特有の課題に対処する。

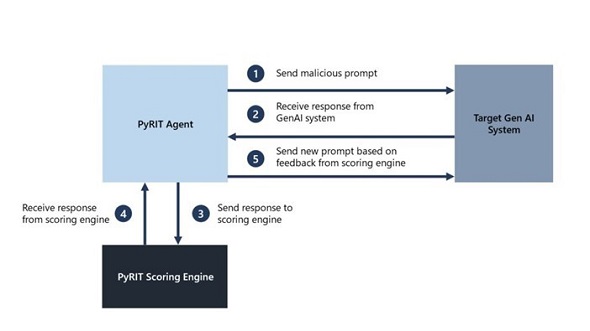

生成AIのためのPyRIT

MicrosoftによるとPyRITは、生成AIシステムによる手作業のレッドチーム作業の代替ではなく、面倒な作業を自動化、効率性を向上させるという。PyRITは、リスクの可能性があるホットスポットに焦点を当て、セキュリティ専門家が提供する有害なプロンプトの初期データセットを受け取り、LLM(大規模言語モデル)エンドポイントを使用してさらに有害なプロンプトを生成する自動化コードを提供する。さらに、生成AIシステムからの応答に基づいて戦術を変更し、生成AIシステムへの次の入力を生成する。自動化は、目標が達成されるまで続く。

PyRITのコンポーネント

PyRITは5つのインタフェースによって実行される。

1.ターゲット

PyRITは、さまざまなターゲット定式化、Webサービスや組み込みアプリケーションをサポートする生成AIレッドチーム用の汎用(はんよう)ツールだ。テキストベースの入力用に設計されているが、他の様式にも拡張できる。「Microsoft Azure OpenAI Service」「Hugging Face」「Azure Machine Learning Managed Online Endpoint」のモデルとの統合をサポートしており、指定されたターゲットに対するAIレッドチーム演習用のbotとして機能する。

2.データセット

セキュリティ専門家はPyRITを使用してプロービング指示をエンコードし、静的で悪意のあるプロンプトや動的なプロンプトテンプレートを利用して、複数の危害カテゴリーの自動探索ができる。

3.スコアリングエンジン

拡張可能なスコアリングエンジンには、古典的な機械学習分類器を使用する方法と、自己評価のためのLLMエンドポイントを使用する方法の2つのオプションがあり、ユーザーはAPIとして「Azure AI Content」フィルターを使用できる。

4.攻撃戦略

PyRITは、シングルターンとマルチターンの両方の攻撃戦略をサポートしており、前者は計算速度が速く、後者はより現実的な敵対行動に対処できる。

5.メモリ機能

PyRITのツールは、中間的な入力と出力のやりとりを保存するためのメモリ機能が搭載されており、詳細な分析が可能になる他、PyRITエージェント間で情報共有も可能だ。

関連記事

あなたの会社に「レッドチーム」はありますか? 実践形式のセキュリティ評価サービスの需要が高まる

あなたの会社に「レッドチーム」はありますか? 実践形式のセキュリティ評価サービスの需要が高まる

ITRは、国内レッドチームサービス市場の規模推移と予測を発表した。2022年度の売上金額は、対2021年度比で30.9ポイント増の28億8000万円。2022〜2027年度の年平均成長率を11.1%と見込み、「2027年度の売上金額は約49億円に上る」と予測している。 Microsoft、任意のデータで生成AIサービスを構築できる「Azure OpenAI Service On Your Data」を提供開始

Microsoft、任意のデータで生成AIサービスを構築できる「Azure OpenAI Service On Your Data」を提供開始

Microsoftは、「Azure OpenAI Service」で独自のデータを使用できる新機能「Azure OpenAI Service On Your Data」の一般提供を開始した。 「プロンプトインジェクション」「ジェイルブレイク」など5項目を診断 生成AI診断サービスをラックが提供開始

「プロンプトインジェクション」「ジェイルブレイク」など5項目を診断 生成AI診断サービスをラックが提供開始

ラックは、生成AIシステムのセキュリティを強化するサービス「生成AI活用システム リスク診断」の提供を開始した。生成AIを使ったシステムに特有の脆弱性が含まれていないかどうかを評価し、改善点をレポートする。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.