生成AIは何に悪用されている? Google DeepMindなどGoogleの3部門が論文を発表:約200件の報道記事を分析

Google DeepMindなどGoogleの3部門が共同で、生成AI技術が現在、どのように悪用されているかを分析した論文を発表した。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

GoogleのAI(人工知能)部門であるGoogle DeepMindは2024年8月2日(米国時間、以下同)、生成AI技術が現在、どのように悪用されているかを分析した論文を発表した。

同論文は、GoogleのJigsaw部門およびGoogle.orgと共同で作成され、査読前論文を投稿するサーバ「arXiv」で2024年6月21日に公開された。Jigsawは、開かれた社会に対する脅威を探求し、拡張可能な解決策を生み出す技術を開発している。Google.orgは、Googleの慈善事業部門。同論文は、責任あるAIの開発、使用を推進するGoogleの取り組みの一環として執筆された。

論文をまとめた研究チームは、既存の学術文献を踏まえ、2023年1月から2024年3月までにメディアで公開された、生成AI技術の悪用事例に関する約200件の報道記事を定性的に分析した。これにより、生成AIを悪用する一般的な手口を定義、分類し、この技術の新たな悪用パターンや侵害パターンを発見した。

生成AIを悪用する手口の主な2つのカテゴリーとは

画像、テキスト、音声、動画などを生成できる生成AIモデルは、創造性を高めるユニークで魅力的な手段だ。だが、オーダーメイドのリアルなコンテンツを生成できるこれらのモデルの能力は、脅威アクターにより不適切な方法で使用される可能性もある。

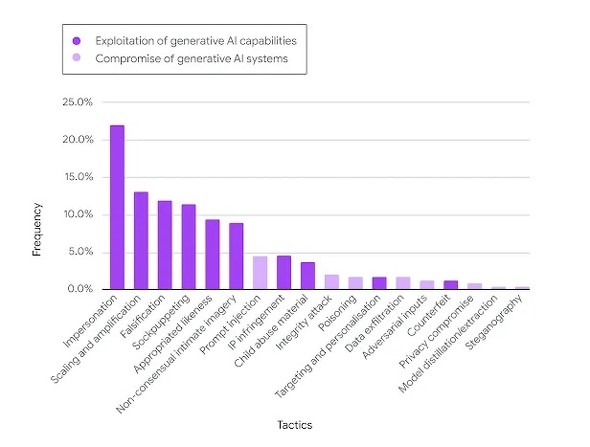

研究チームがメディア報道を分析した結果、生成AIを悪用する手口には、「生成AIの機能の悪用」と「生成AIシステムの侵害」という2つの主なカテゴリーがあると分かったという。

生成AIの機能を悪用する手口の例としては、公人になりすますために、人間のリアルな偽画像を作成するといったものがある。生成AIシステムを侵害する手口の例としては、モデルのセーフガードを解除する「ジェイルブレーク」や、敵対的な入力を用いて誤作動を引き起こすことなどが含まれている。

約200件の記事で報じられた事例では、脅威アクターが、簡単にアクセスできる消費者レベルの生成AIツールを、高度な技術的スキルが不要な方法で悪用するケースが多く見られた。

個々の手口としては、なりすまし、誇張、改ざんが、使用頻度の上位3つを占めた。

観察された手口の一部(なりすまし、詐欺、合成ペルソナなど)は、生成AIの発明以前から用いられてきたものだ。生成AIツールの利用が広がれば、情報操作のコストやインセンティブが変化し、こうした古くからの手口が新たな有効性や可能性を持つ恐れがあるとしている。

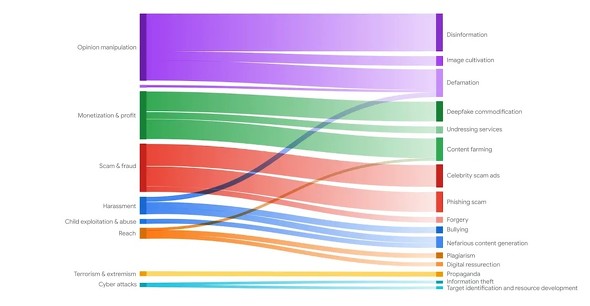

脅威アクターの目的と生成AIの悪用戦略の組み合わせ

研究チームは、脅威アクターがさまざまな目的を追求するために、生成AIを悪用する手口をどのように組み合わせているかを分析し、これらの手口の組み合わせを、「戦略」としてラベル付けした。下の図は、脅威アクターがどの目的を追求するために、どの戦略を採用しているかを示している。

約200件の記事で報じられた事例のほとんどは、世論に影響を与えることや、利益の獲得、詐欺の実行(上図グラフの左側の上位3つ)を目的として行われていた。

生成AIの新たな悪用の手口が、倫理的な懸念を引き起こしている事例もある。生成AIを用いた政治的な働き掛け(Reach)の新形態がその一つだ。政府高官が生成AIの使用を開示せずに、突然、有権者の質問に親しみやすい文言で回答するようになったり、活動家が、亡くなった犠牲者の声をAIで生成して、銃制度改革を訴えたりするケースがある。

データセットの注意点

研究チームは、分析に使用したデータセットが約200件の報道記事という限られたサンプルであることに注意を促している。メディア報道はセンセーショナルな事例を優先する可能性があるため、このデータセットは特定の種類の悪用に偏っている可能性がある。生成AIシステムは非常に新しいため、関係者にとって、悪用の発見や報告が難しい場合もあるという。

潜在的な悪用に先手を打つ

研究チームは、この論文が明らかにした生成AIの悪用のさまざまな手口や、それらについての洞察は、生成AIの悪用による脅威から人々を守るために、さまざまな取り組みを進める機会があることを示していると述べている。

こうした取り組みには、広範な生成AIリテラシーキャンペーンの推進、脅威アクターから市民を守るためのより良い介入策の策定、生成AIを悪用するための操作的な戦略を発見し、拒否できるように人々を啓発することなどが含まれる。

関連記事

生成AIでサイバー攻撃が「より迅速で高精度な攻撃」に進化 バラクーダがランサムウェアの攻撃パターンを調査

生成AIでサイバー攻撃が「より迅速で高精度な攻撃」に進化 バラクーダがランサムウェアの攻撃パターンを調査

バラクーダネットワークスは、脅威レポート「バラクーダの注目する脅威:AI戦術の定着でランサムウェア攻撃の報告件数が倍増」を発表した。「サイバー犯罪者が生成AIを使用して、より迅速で精度の高い攻撃を行っていることを検証した」としている。 ドワンゴのサイバー攻撃被害、すぐに「ニコニコ動画(Re:仮)」を公開できた理由

ドワンゴのサイバー攻撃被害、すぐに「ニコニコ動画(Re:仮)」を公開できた理由

大手出版事業者のKADOKAWAがランサムウェアを含む大規模なサイバー攻撃の被害に遭った。子会社であるドワンゴの動画配信サービス「ニコニコ動画」が停止し大きく話題となる中、「被害を受けなかった動画システムやデータ」を基にした「ニコニコ動画(Re:仮)」が公開された。仮サービスをいち早くリリースできた背景にあるのが、2024年3月に完了していた動画配信基盤のAWS移行だ。2024年6月に開催された「AWS Summit Japan」では、ドワンゴの久保田陽介氏が、動画配信基盤のAWS移行に踏み切った背景や作業過程、移行から得られたメリットを解説した。 「サイバー攻撃の被害は警察署に通報を」――警視庁が解説する最新の脅威動向、セキュリティ対策の基本

「サイバー攻撃の被害は警察署に通報を」――警視庁が解説する最新の脅威動向、セキュリティ対策の基本

サイバー攻撃の脅威を対岸の火事と捉える経営者は珍しくない。だが現実は、企業規模を問わず、脆弱性のあるシステムを標的にサイバー攻撃が仕掛けられ、システムを使用していた自社はもちろん、取引先にまで影響を及ぼすケースが起きている。東京商工会議所が主催したセミナーに登壇した警視庁の担当者が、最新の脅威動向、サイバーセキュリティ対策の基本を解説した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ