アニメ「こうしす!」に学ぶ、「セキュリティとAI」の未来を予想しながら今からできるリスク対策とは:ITmedia Security Week 2024 春

2024年5月29日、アイティメディアが主催するセミナー「ITmedia Security Week 2024 春」で、テレビ放送も行われたアニメ作品「こうしす! こちら京姫鉄道 広報部システム課」の監督・脚本を務める、京姫鉄道 代表社員CEO 井二かける氏が「AIブームとセキュリティ、アニメ『こうしす!』監督が考える今と未来」と題して講演した。ブームとなっているAIの業務活用にはリスクもあり、仮に全面禁止してもシャドーITのリスクがある。講演で井二氏は「AIに関する数々のリスクとどのように向き合えばよいのか」について、現場の視点と「こうしす!」流の未来予想を交えて解説した。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

「こうしす!」は技術系コメディー自主制作アニメとしてYouTubeで公開されているだけでなく、映像、音声そして素材に関してもクリエイティブ・コモンズ表示 4.0 国際ライセンスの下で公開されており、「Enterprise Edition」として商用利用も可能なアニメーションだ。

その内容はエンジニアにとって身近なもので、セキュリティに親しむ上でのヒントがたくさん隠れている。@ITでも「支線」が連載されており、読者には既になじみの深い作品かもしれない。講演直後には地上波でも放送が開始されたばかりだ。監督・脚本を担当する井二氏は、「物語の力で、IT・セキュリティをもっと楽しく」をモットーに活動している。

井二氏は「AIブームとセキュリティ」というテーマで講演を準備するに当たり、生成AI(人工知能)に講演のアジェンダを作成させたという。本稿でも、そのアジェンダに従い、「生成AIの現状と企業での活用事例」「生成AIがもたらすセキュリティリスク」「リスクに向き合うための戦略」「未来予想と展望」の順で講演内容を要約する。

生成AIの現状は?

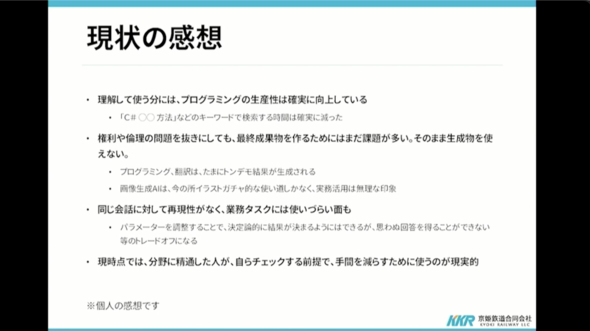

多くの企業はAI活用について模索し続けており、それをどう実務でも使うかを検討している段階にあるのが現状だ。得意分野はなんとなく理解できるものの、実務に生かす上ではAIをどう使うべきか、分からない部分もが多い。

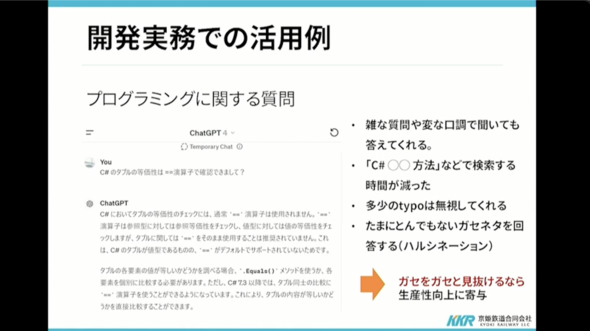

井二氏はプログラミングに関するAIへの質問を例に、その回答は「たまにとんでもないガセネタを回答する(ハルシネーション)」としつつ、「ガセをガセと見抜けるなら、生産性は向上する」とも指摘する。

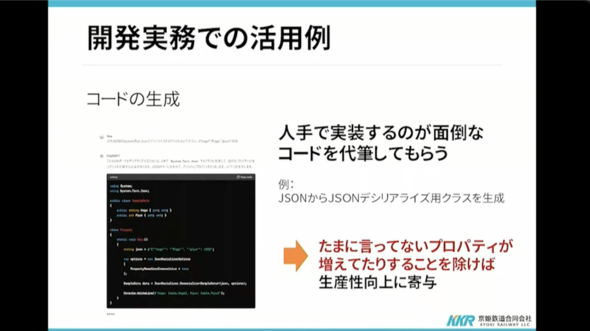

その他、人手で実装するのが面倒なコードを代筆するような活用も、「たまに言っていないプロパティが増えていることを除けば」生産性向上に寄与するという。

作品制作の面では、アイデア出しやSF考証などそれなりに役に立つこともあれば、「方言を調べようとして、その意味を聞くと、ウソが返ってくることもあり、あまり書き言葉に使われない方言の回答精度は悪い」と評価する。

井二氏は「個人の感想として」という前置きをしつつ、「理解して使う分には生産性は確実に向上している。現時点では、分野に精通した人が、自らチェックする前提で手間を減らすために使うのが現実的だ」とまとめた。

生成AIがもたらすセキュリティリスクを考える

生成AIにおいてセキュリティリスクとして考えられることを見てみよう。

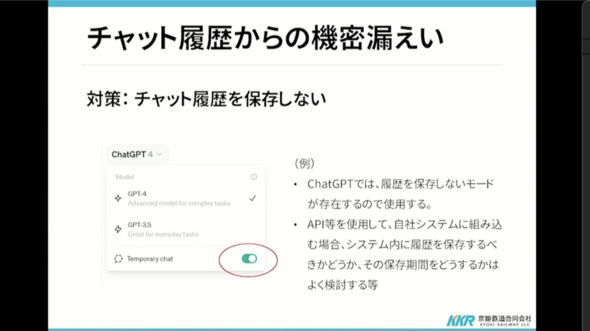

井二氏はまず、「チャット履歴の漏えい」について解説する。「ChatGPT」などにおけるチャットのやりとりそのものが漏えいするリスクのことだ。ID/パスワードなど認証情報が盗まれることで起き得るだけでなく、サービス側の脆弱(ぜいじゃく)性などでも起き得る。

この問題は、ChatGPTの「Temporary chat」(テンポラリチャット)を設定することで緩和できる可能性があるが、APIを利用してシステムに組み込む場合、システム内に履歴を保存した部分もリスクとなるので「履歴を参照するポリシーや、ログの保存ポリシーも検討すべきだ」と井二氏は述べる。

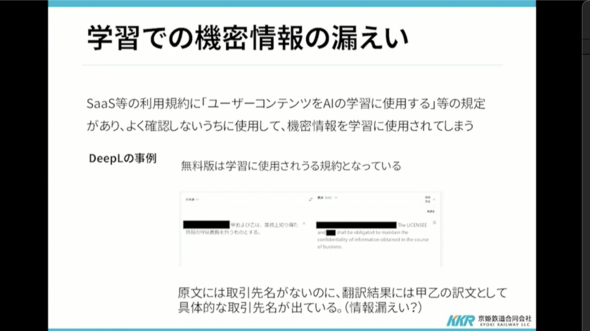

機械学習に使用されることによる機密情報の漏えいも大きなリスクだ。例えば翻訳サービス「DeepL」では、無料版を使用すると規約上、その内容が機械学習に使用され得る。このため、機密保持契約などで「甲」「乙」などの表記があるものを翻訳すると、具体的な社名、氏名が“翻訳”されてしまう事例がある。これも、情報漏えいの新しい形だ。

この対策としては、初めから機械学習に使用しないことが規約として定められているサービス、またはプランを選択することがある。また、ローカルLLM(大規模言語モデル)など外部には情報が出ていかないものを活用するといった運用も考えられるが、従業員に配布したPCでは性能が足りないのが現状だ。

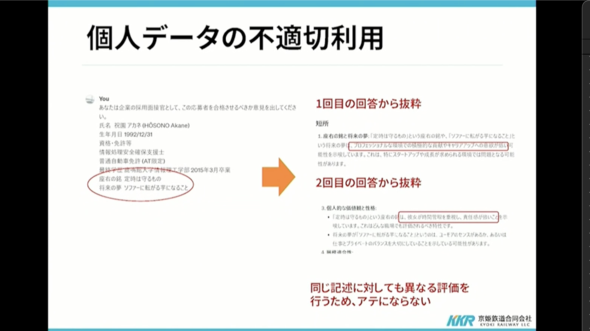

重要なリスクとして考える必要があるのは「個人データの不適切な利用」だ。例えば「企業の採用試験において、志望者のデータをChatGPTに入力して合否を判断させる」ケースがある。この場合、前述の機械学習における漏えいリスクだけでなく、「本人の採用に関係する情報に基づいて判断されたかどうか」という問題が残る。よく「応募者は、AIを使用した選考に、応募者が提供する個人情報を使用することに同意します」と同意を求めることがあるが、「同意を得たからといって万事OKなのか?」と井二氏は疑問を呈する。

井二氏はこの疑問に関して、志望者のデータを「こうしす!」登場人物のプロフィールにして、試してみたという。プロフィールには「座右の銘:定時は守るもの」「将来の夢:ソファに転がる芋になること」という表記があるが、AIはこれを基に「プロフェッショナルな環境での積極的な貢献やキャリアアップの意欲が低い」と評価する。同じデータと同じ分析の指示をもう一度AIに対して行ったところ、今度は「彼女が時間管理を重視し、責任感が強いことを示唆する」と判断した。同じ記述に対しても繰り返すと異なる評価になるので、これでは当てにならないことが理解できる。

井二氏は「気にすべきは、人生を左右する個人データの処理において、不正確な情報、関連性のない情報に基づき、AIが勝手に判断していないかどうか。情報セキュリティや個人情報保護の問題もあるが、それ以前に同意があっても倫理的に問題がある可能性がある」と指摘する。

類似例としてはリクナビが内定辞退率のデータを、本人の十分な同意もなく内定辞退予測に使用して企業に販売していたこともあり、「今後、AIに対して『この応募者が内定を辞退する確率は?』と聞くといったことも想定できる」(井二氏)

- 詳報・リクナビ問題 「内定辞退予測」なぜ始めた? 運営元社長が経緯を告白(1/3 ページ) - ITmedia NEWS

- リクナビの内定辞退率問題、トヨタや京セラなど35社に個人情報保護委員会が指導 - ITmedia ビジネスオンライン

この対策は「AIの透明性を高める」といったところに落ち着くと思われるが、どのデータに基づき、どう判定されたのかを明確にするのは現状では非常に難しい。現状を考えると、セキュリティ以外でもさまざまなリスクがあることから、「業務に全面的にAIを活用する」と宣言してしまうと、あらゆるところに角が立つ不幸な状況となる。「AI開発者によって、技術的に解決できることを期待したい」(井二氏)

「やってはいけない対策」とは

井二氏は、リスクに向き合うための戦略についても触れる。ここではAIに限らず、セキュリティの原則として「精神論的セキュリティ対策は行うな」と訴える。

ここでいう「精神論的セキュリティ対策」とは、「AIを使って情報漏えいを起こしたとしたら、それは自覚が足りないからだ」と、精神論に帰結するような考え方だ。井二氏は「そういう面もある」としつつも、「精神論的セキュリティ対策は隠蔽(いんぺい)を引き起こすリスクがあり、『自覚が足りない』『インシデントゼロを目指せ』といった考え方は、絶対にやってはいけない」と力を込める。

井二氏は「こうしす!」からの場面を引用し、「インシデントはゼロとする、そうしなければ懲戒処分だ」とした現場では隠蔽が行われ、結果として「報告は0件」となったシーンが紹介される。自覚が足りないと責めることは、従業員一人の問題に矮小(わいしょう)化されてしまう。

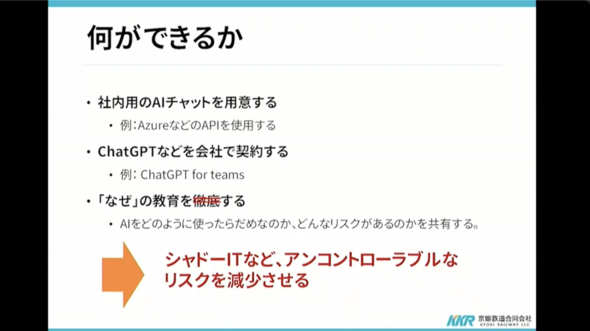

井二氏は、効果のない対策として「AIを全面的に遮断する」「利用禁止を伝える」なども想定できるという。しかし、AIを生産性向上のために活用することは、もはや避けられないのが現実だ。「使いたいという需要がある以上、それに応えるべきだ。ゼロリスクではなく、トータルでリスクをコントロールしよう」(井二氏)

例えばChatGPTなどのサービスを企業として契約し、活用の道を提供すると同時に、「AIをどのように使ったらダメなのか、どんなリスクがあるのかを共有する」ことが対策として挙げられる。

井二氏はここで再度「こうしす!」のワンシーンを引用する。そのシーンではこのようなせりふがつづられている。

事故は必ず起きる。それが当然だ

責任事故ゼロインシデントゼロ これは目標にすぎん。

隠蔽や言葉遊びで実現したゼロに意味はない。

今一番大切なのは、お客さまを安全に送り届けることだ

未来予測:未来は明るいか、それとも……

井二氏はAIの未来について、「業務での利用は現状の延長線上で性能が向上し、さまざまなタスクでAIが自律的に行えることが増えるだろう」と予測する。一方で、どこかで一度限界を迎えて幻滅期が訪れた後に「適材適所で使われるようになり、AIを活用しているかどうか意識されなくなるだろう」とも予測する。

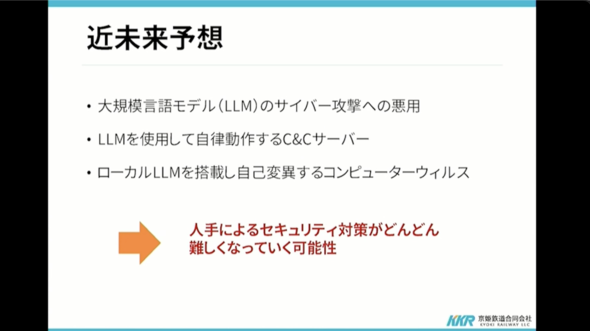

未来では、「セキュリティにおけるAI」はどうなるのだろうか。井二氏は「既に存在していることも考えられるが、ごく近い将来、LLMがサイバー攻撃に悪用され、将来的にはローカルLLMを搭載し、自己変異するコンピュータウイルスも出てくるかもしれない」と予想する。

「事故ゼロはどんどん困難になっていく。『精神論的なセキュリティ』で事故ゼロを目指すのではなく、リスクベースでトータルのセキュリティを確保することが大切だ」(井二氏)

関連記事

生成AI活用で内部統制は必要か、専門家の意見が真っ二つに割れる理由とは チェック・ポイント調査

生成AI活用で内部統制は必要か、専門家の意見が真っ二つに割れる理由とは チェック・ポイント調査

チェック・ポイント・ソフトウェア・テクノロジーズは、サイバーセキュリティとAI活用の現状に関する調査結果を公開した。AI導入に関しては、内部統制とガバナンスポリシーの重要性に対する調査結果が浮き彫りになった。 生成AIのセキュリティに関する規則が策定されている企業は20%未満 IPAが調査結果を発表

生成AIのセキュリティに関する規則が策定されている企業は20%未満 IPAが調査結果を発表

IPAは、「AI利用時の脅威、リスク調査報告書」を公開した。業務でAIを利用している人のうち、6割がAIのセキュリティに関して脅威を感じており、7割がセキュリティ対策は重要だと考えていることが分かった。 NIST、LLMのネタバレ制御など3つのシナリオでAIの社会的リスクと影響を評価するプログラム「ARIA」を発表

NIST、LLMのネタバレ制御など3つのシナリオでAIの社会的リスクと影響を評価するプログラム「ARIA」を発表

NISTは、AIのリスクと影響を評価するプログラム「ARIA」を発表した。NISTは、ARIAの成果を通じて、AI技術の設計、開発、リリース、使用におけるガイドライン、ツール、方法論および指標を提供するという。

Copyright © ITmedia, Inc. All Rights Reserved.