大規模言語モデルの「創発的」能力(Emergent Abilities of Large Language Models)とは?:AI・機械学習の用語辞典

用語「創発」について説明。大規模言語モデルの計算量やパラメーター数が非常に大きくなると、“あるところ”を境に、突然、新しい能力を獲得して性能が大きく向上する現象を指す。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

用語解説

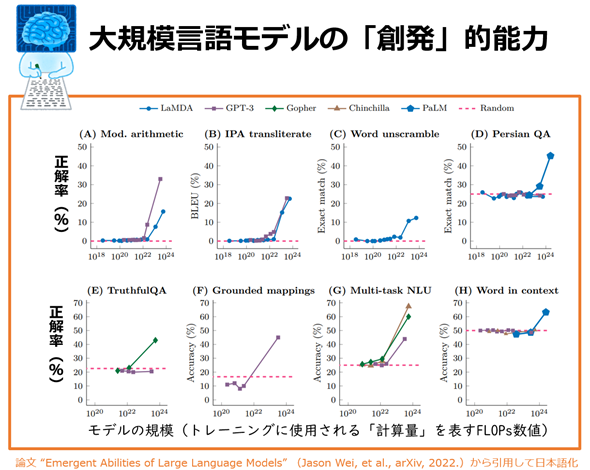

大規模言語モデルにおける創発的能力(Emergent Abilities of Large Language Models、あるいは単に「創発」)とは、大規模言語モデルの計算(Compute)量(もしくはパラメーター数=モデルのサイズ)が非常に大きくなると、“あるところ”を境に、突然、(新しい能力を獲得して)性能が大きく向上する現象のことである(図1)。なお創発的能力は、元の論文で以下のように定義されている。

ある能力が、より小さなモデルには存在しないが、より大きなモデルには存在する場合、その能力は創発的である。

(An ability is emergent if it is not present in smaller models but is present in larger models.)

図1 創発(Emergent Abilities of Large Language Models)のイメージ

図1 創発(Emergent Abilities of Large Language Models)のイメージ引用論文“Emergent Abilities of Large Language Models”(Jason Wei, et al., arXiv, 2022.)

図中のLaMDA/GPT-3/Gopher/Chinchilla/PaLMは「モデル名」を指し、Randomは最低限の性能の基準となる「ランダムな出力の場合の性能(正解率)」を指す。

図中の規模とは、英語の「scale(スケール)」を指す。

図中のFLOPsとは、「number of FLoating-point OPerationS(浮動小数点の演算の数)」の略語で、AIモデルの「計算量」を測る指標のことだ。なお、コンピューターの処理速度を測る指標である「FLOPS(FLoating-point Operations Per Second)」(※「S」が大文字である点が違う)とは別物なので注意してほしい。

図中の(A)〜(H)は、ベンチマークや論文などの「タスク」を指す。(A)Mod(ified) Arithmetic/(B)IPA transliterate/(C)Word unscrambling/(D)Persian QAは、いずれもグーグルのBIG-benchベンチマークにあるタスク。その他は、TruthfulQAベンチマークのタスク、論文「Mapping Language Models to Grounded Conceptual Spaces」のタスク、論文「Measuring Massive Multitask Language Understanding」のタスク、The Word-in-Context(WiC)データセットのタスクである。

創発的能力を獲得する“あるところ”(スケールの大きさ)は、タスクやモデルによって異なる可能性があるが、図1を見ると計算量のFLOPsは1023のあたり(もしくは図1には示されていないがパラメーター数なら1000億のあたり)になっている。これらの数値がある程度の参考目安になるだろう。

なお、本稿で説明している創発的能力は、Google ResearchやStanford University/UNC Chapel Hill/DeepMindの人らが2022年6月に公開した論文『Emergent Abilities of Large Language Models』に基づいた内容となっている。ちなみに、その論文内では、「新しい能力の獲得」という質的な変化を「相転移(Phase transition)」とも表現している。また創発的能力については、2022年11月に公開されたGoogle Researchのブログ記事でも説明されており、こちらの方が論文よりも読みやすいだろう。

「創発」に類似する用語として「グロッキング(Grokking)」がある(「Grok」とは「しっかりと完全に理解/把握する」という意味)。別用語なので詳細は割愛するが、OpneAIなどが2022年1月に発表した論文「Grokking: Generalization Beyond Overfitting on Small Algorithmic Datasets」では、ニューラルネットワークの過学習(オーバーフィッティング)をはるかに超えて訓練し続けることで、急激な汎化性能の向上が見られることを報告している。

Copyright© Digital Advantage Corp. All Rights Reserved.