Cohereの研究部門が高性能多言語モデル「Aya Expanse」を発表 日本語含む23言語で利用可能:ベンチマークで他の主要オープンウェイトモデルをどれぐらい上回ったのか?

Cohereの研究部門は高性能な多言語モデルファミリー「Aya Expanse」を発表した。23の言語にわたって優れた性能を発揮し、ベンチマークで他の主要なオープンウェイト(重み)モデルを上回っている。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

AI(人工知能)スタートアップ(新興企業)のCohereの研究部門であるCohere For AIは2024年10月24日(カナダ時間)、高性能な多言語モデルファミリー「Aya Expanse」を発表した。

Aya Expanseは23の言語にわたって性能を発揮し、ベンチマークで他の主要なオープンウェイト(重み)モデルを上回っている。

Aya Expanseは、Cohere For AIが主導して進めているグローバルな取り組みである「Aya」の最新の成果だ。Ayaは、AIがカバーする言語を増やす新しいモデルとデータセットを作成するオープンサイエンスプロジェクト。119カ国の3000人以上の独立研究者が参加している。多言語AIの最先端技術を発展させ、世界中の人々や文化間のギャップを埋めることを目的としている。

Cohere For AIは、多言語研究への継続的なコミットメントの一環として、また多言語AIのフロンティアを前進させるために、Aya ExpanseをKaggleとHugging Faceでオープンウェイトモデルとして公開している。Kaggleは、データ分析や機械学習のコンペティションプラットフォーム。Hugging Faceは、AIモデルの開発、トレーニング、デプロイ(展開)に広く使われているオープンソースプラットフォームだ。

ベンチマークで他の主要オープンウェイトモデルをどれぐらい上回ったのか?

Aya Expanseは、80億パラメーターモデル「Aya Expanse 8B」と320億パラメーターモデル「Aya Expanse 32B」がある。Aya Expanse 8Bは、世界中の研究者にとってAyaの画期的な技術を利用しやすくするものであり、Aya Expanse 32Bは、最先端の多言語機能を提供する。

Aya Expanse 32Bは、ベンチマークでGemma 2 27B、Mistral 8x22B、Llama 3.1 70B(Aya Expanse 32Bの2倍以上の規模)を上回っている。

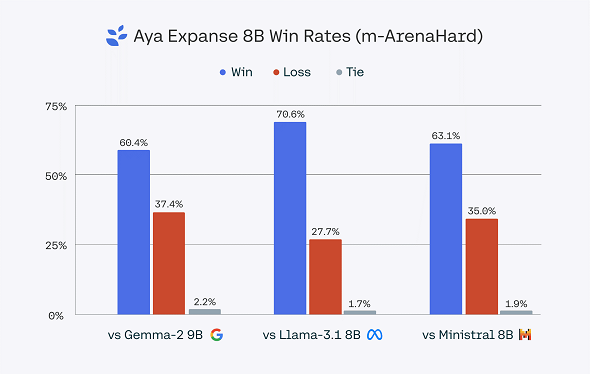

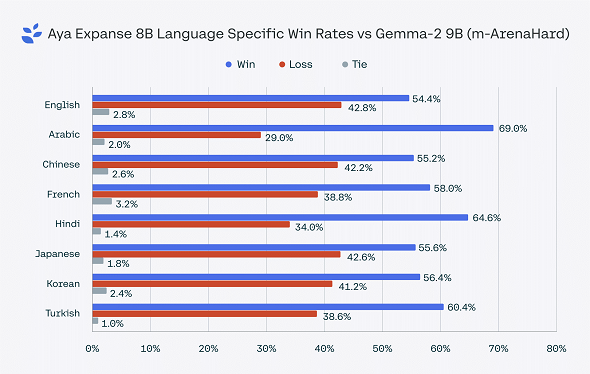

Aya Expanse 8Bは、Gemma 2 9B、Llama 3.1 8Bおよび最近リリースされたMinistral 8Bといった同パラメータークラスの主要なオープンウェイトモデルに対する勝率が60.4〜70.6%に達している。

Aya Expanseに結実したブレークスルー

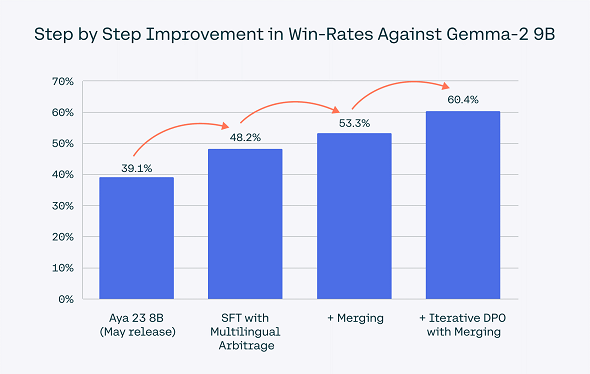

Aya Expanseの開発では、Ayaプロジェクトで研究課題を克服するために導入された以下のトレーニング手法のブレークスルーが大きく貢献した。

データ裁定

多言語機能に適した合成データ(※)を生成するために、データ分布に基づいて戦略的にさまざまな“教師”モデルを選択する新しいデータサンプリング手法を指す。

(※)エキスパートモデルや“教師”モデルが他のモデルをトレーニングするために生成するデータ

グローバルな嗜好への対応

モデルトレーニングの後期段階に行われる嗜好(しこう)トレーニングは、欧米中心のデータセットに過剰に適合することが多いため、さまざまな文化的、言語的観点を考慮し、嗜好トレーニングを大規模な言語環境に拡張し、最適化を図った。これによって一般的な性能と安全性の両方が大きく向上した。

モデルのマージ

各段階で複数の候補モデルの重みを組み合わせ、より高い汎用(はんよう)性と性能の実現を目指すモデルマージに関する研究成果を導入した。

手法の統合

これの手法を全て組み合わせ、Aya Expanseのための1つのトレーニングレシピを作成した。これらの手法それぞれが段階的な改善を可能にし、Aya Expanseがベンチマークで同パラメータークラスの他の主要モデルを大きく上回る結果につながった。

このトレーニングレシピは大規模モデルでも効果を発揮し、23の言語におけるAya Expanse 32BのGemma 2 27B、Mistral 8x22B、Llama 3.1 70Bに対する勝率は、51.8〜76.6%となっている。

なお、Aya Expanseは以下の23言語に対応している。アラビア語、中国語(簡体字、繁体字)、チェコ語、オランダ語、英語、フランス語、ドイツ語、ギリシャ語、ヘブライ語、ヒンディー語、インドネシア語、イタリア語、日本語、韓国語、ペルシア語、ポーランド語、ポルトガル語、ルーマニア語、ロシア語、スペイン語、トルコ語、ウクライナ語、ベトナム語。

関連記事

Cohere、強力でスケーラブルなRAG最適化LLM「Command R+」を発表

Cohere、強力でスケーラブルなRAG最適化LLM「Command R+」を発表

Cohereは、同社のプロダクトの中で「最も強力でスケーラブル」とする大規模言語モデル「Command R+」を発表した。 Cohere、企業ワークロード向けLLM「Command R」のファインチューニング機能を提供開始

Cohere、企業ワークロード向けLLM「Command R」のファインチューニング機能を提供開始

Cohereは、2024年3月に発表したエンタープライズワークロード向け大規模言語モデル「Command R」のファインチューニング機能を提供開始した。 生成AIの活用を検討する企業が「RAG」を導入すべき5つの理由 Cohere

生成AIの活用を検討する企業が「RAG」を導入すべき5つの理由 Cohere

Cohereは、企業が生成AI活用を推進する上でRAGが重要な役割を果たすとし、5つの理由を解説した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.