自己教師あり学習(Self-Supervised Learning:SSL)とは?:AI・機械学習の用語辞典

用語「自己教師あり学習」について説明。ラベルなしの大量データセットを使って、プレテキストタスク(疑似的なラベルが自動生成された代替のタスク)を解くための事前学習を行う学習方法のこと。その後、ターゲットタスクを解くために、(少量の)別のデータセットを使って事前学習済みモデルをファインチューニングする。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

用語解説

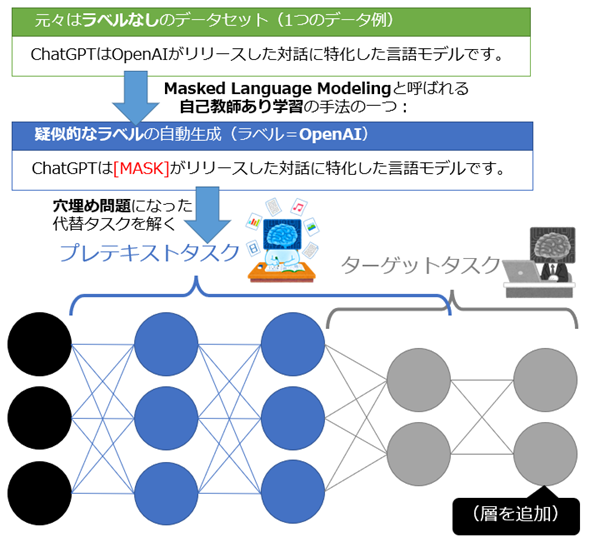

機械学習(厳密にはニューラルネットワーク)における自己教師あり学習(Self-Supervised Learning:SSL)とは、教師ラベルが付与されていない大量のデータセットを使って、プレテキストタスク(Pretext task)と呼ばれる「疑似的なラベルが自動生成された代替のタスク」を解くための事前学習を行う学習方法のことである。その後、本来の目的であるターゲットタスク(Target task、下流タスク)を解くために、(少量の)別のデータセットを使ってその事前学習済みモデルを教師あり学習(もしくは教師なし学習)で再トレーニング(基本的にはファインチューニング)する(図1)。

自己教師あり学習は、コンピュータビジョンの画像や、自然言語処理のテキストなどに関するタスクで採用されている。なお、英語の「Pretext(プレテキスト)」とは、「口実」「言い訳」「名目」「うわべ」「見せかけ」などの意味で、自己教師あり学習では「疑似的」と訳されることもある。勘違いしやすいが「テキスト(文章)」という意味ではないので注意してほしい。コンピュータビジョンにおける自己教師あり学習でも「プレテキストタスク」という用語が使われる。

これまで一般的だった「教師あり学習」では、ラベルの付与を(基本的に)人力でする必要があるため、データが大量にある場合には非常に多大なコストがかかるという問題があった。一方、最近人気を集めている「自己教師あり学習」では、疑似的なラベルを自動生成するため、そのコストが発生しないというメリットがある。

コンピュータビジョンの画像における疑似的なラベルの自動生成とは、例えばランダムなクロップ(切り抜き)や色のゆがみなどの変換を行って画像データを拡張(水増し)して、画像間を比較する代替タスクに置き換えることなどだ。このタスクでは、基軸となる元の画像は「アンカー(anchor)」、アンカーと元が同じ拡張画像は「正例(positive examples)」、アンカーと元が異なる拡張画像は「負例(negative examples)」などと呼ばれ、アンカーと負例の距離を最大化しながら、アンカーと正例の距離を最小化するように学習する。これは対照学習(Contrastive Learning、Contrastive Self-Supervised Learning、例:「SimCLR」)と呼ばれる、自己教師あり学習の代表的な学習手法の一つである。この他にもMasked Image Modeling(例:「SimMIM」)などさまざまな手法が考案されてきている。

自然言語処理のテキストにおける疑似的なラベルの自動生成とは、例えばそのテキストの一部をマスクで非表示にした穴埋め問題(Masked Language Modelingと呼ばれる学習手法)や、2つの文章が連続するかしないかを二値分類する問題(Next Sentence Predictionと呼ばれる学習手法)といった代替タスクに置き換えることなどだ。これらは、TransformerのBERTなどの事前学習で採用されている、自己教師あり学習の代表的な学習手法である。

自己教師あり学習は「ラベルなし」の学習であるため、教師なし学習の一種と見なされることもある。また、自己教師あり学習と半教師あり学習(Semi-Supervised Learning)は非常に似ている概念ではあるが、自己教師あり学習がまずは「ラベルなし」のデータセットで学習するのに対し、半教師あり学習は「ラベルあり」+「ラベルなし」という両方のデータセットを使って学習する(つまり一部のデータセットにラベルを付与する必要がある)、という違いがある。

Copyright© Digital Advantage Corp. All Rights Reserved.