フレーム問題(Frame problem)とは?:AI・機械学習の用語辞典

用語「フレーム問題」について説明。有限の処理能力しか持たないAI/ロボットは、無限の可能性を含む現実的な課題において、その課題に関係のあることだけを選び出して(=フレームを設定して)適切に実行するのが難しいことを指す。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

用語解説

AI(人工知能)研究分野におけるフレーム問題(Frame problem)とは、AI搭載のロボット(以下、AIロボット)が何かの課題を実行しようとした際に、その課題に関係のあることだけを選び出して(=フレームを設定して)、適切に実行するのは、現実的には非常に難しい、という問題を指す。

当然ながら、AIロボットの情報処理能力は有限である。それに対し、現実に起こり得る可能性は無限に近いはずだ。例えば完全自動運転車を作ると仮定してみよう。シンプルに考えれば、法定速度内で前の車とぶつからないように、決められた車道内を信号などの交通ルールを守りながら、走ればよいだろう。しかし現実にはそれだけでは済まない。猫が道から飛び出してきたり、土砂崩れの岩が落ちてきたりする可能性がなきにしもあらずだ。そういった想定外の可能性は、考えれば考えるほど検討すればするほど無限のように出てきてしまうだろう。

つまり、「ここからここまでの可能性を検討する」という枠(フレーム)をあらかじめ設定しなければ、AIはその可能性を検討し続けてしまい、その検討処理には無限の時間がかかってしまう、ということになりかねない。もちろんそもそも、そういったフレームの設定自体が非常に難しい(※人間はある程度、無意識にやっているが……)。ちなみに現在の弱いAI/特化型AIは、特定のタスク内にフレームを設定することで、このフレーム問題を回避している例といえるだろう。

フレーム問題の歴史は古い。1969年にJohn McCarthy(ジョン・マッカーシー)氏とPatrick Hayes(パトリック・ヘイズ)氏が数理論理学の問題として提起したことを皮切りに哲学的な議論が始まった。1984年にDaniel Dennett(ダニエル・デネット)氏が論文で示した「フレーム問題の例」が特に有名である。その「例」の内容について、以下に簡単に示しておく。なお、この「例」のディテールは元論文とは異なり、短く分かりやすくなるよう少しアレンジしているので、あらかじめご了承いただきたい。

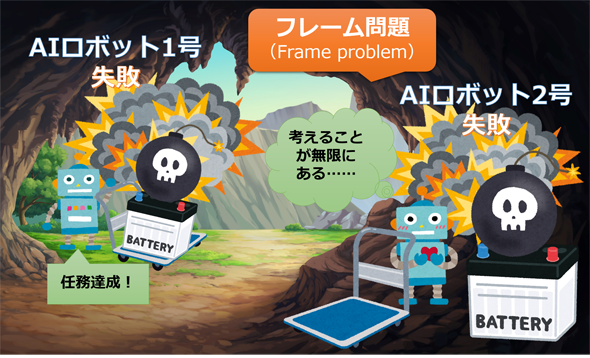

まずAIロボットに「洞窟内にあるバッテリーを取ってきなさい」という指示を与えたとする。AIロボット1号は洞窟に入ると、時限爆弾が上に載った状態のバッテリーを見つけた。そのままバッテリーを台車に載せて、洞窟を出たところ、時限爆弾が爆発してAIロボット1号は壊れてしまった。この失敗の原因は何だろうか。AIロボット1号は、指示通りの課題を適切に解決できたが、現実の問題を解くにはそれだけでは足りなかったからだ。AIロボット1号は、バッテリー以外の危険なもの(時限爆弾)は台車に載せないようにしなければならなかったのだ。

そこで、危険を察知して回避するAIロボット2号が製作され、同じ指示が与えられた。AIロボット2号は同じく、時限爆弾が上に載った状態のバッテリーを見つけた。そこで、バッテリーを運ぶ上での危険性を検討し始めた。「バッテリーの上にある時限爆弾を動かすべきか」「動かすと、天井が落ちてくるのではないか」「動かすと、壁の色が変わるのではない」……と次々と危険の可能性を検討し続けていたところ、時間がかかりすぎて時限爆弾が爆発してしまった。この原因は、課題と関係のないことを無限に検討してしまったためである。確かに「天井が落ちる」や「壁の色が変わる」は危険性と全く関係がないが、これらを一度検討しなければ、爆弾と天井/壁との関係性は理解できないはずだ。このようにロボットAIが検討する/考えるべき対象は無限のように存在するのである。

以上が「フレーム問題の例」である。人間は、天井と爆弾は何の関係もないことを経験的に知っているため、時限爆弾を下ろして、さっさとバッテリーを台車に載せて持ち帰れるはずだ。しかし、AIロボットは人間のようなさまざまな経験を多角的に保有しいるわけではない。

また、人間であっても、フレーム問題を完全/本質的に克服しているわけではない。例えば、ガスが充満しているところで換気扇のスイッチを押して爆発事故を起こしたりする失敗はあり得るだろう。これはフレームの設定ミスといえるのではないだろうか。電気で発火という危険の可能性をフレームから無意識に外してしまっているからだ。とはいえ、通常このようなミスは人間ではあまり起きないので、できるだけ人間と同じようにフレーム問題を解決することが今後のAI研究の目標となるだろう。

Copyright© Digital Advantage Corp. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ