個人なら無料のコーディングAIツール「Amazon CodeWhisperer」などAWSの生成系AI関連発表まとめ:基盤モデルで生成系AIアプリを開発、拡張できる「Amazon Bedrock」も

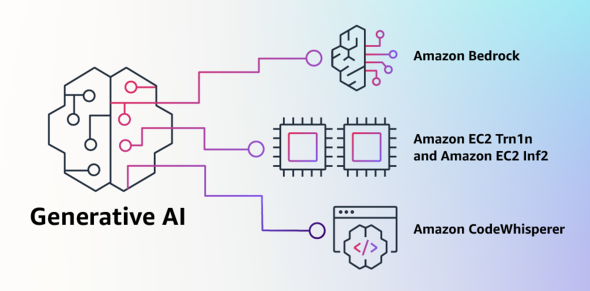

AWSが、生成系AIアプリを開発、拡張できるツールや基盤モデル、専用チップ搭載インスタンス、コーディング支援ツールなどを発表した。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

Amazon Web Services(AWS)は4月13日(米国時間)、生成系AIに関するサービスを幾つか発表した。

AI21 Labs、Anthropic、Stability AIおよびAmazonの基盤モデルをAPIで利用できるようにするサービス「Amazon Bedrock」を発表し、選択できる基盤モデルの一つとして「Amazon Titan」も発表した。共にプレビュー版であり、限定したユーザーが利用している。

「AWS Trainium」と「AWS Inferentia」は、それぞれクラウド上でのモデルの学習と推論に用いる専用のチップだ。Trainiumを搭載し、ネットワークに最適化された「Trn1n」インスタンスと、数千億のパラメーターを含む大規模なモデルの生成系AIアプリケーションに最適化された「AWS Inferentia2」を搭載する「Inf2」インスタンスの一般提供を発表した。

10のプログラミング言語に対応する、AIによるコーディング支援ツール「Amazon CodeWhisperer」の一般提供を発表した。個人ユーザーならAWSアカウントがなくても無料で利用できる。

AWSは、これらの生成系AI関連サービスの発表について以下のように説明している。

生成系AIと基盤モデル

生成系AIは、会話、ストーリー、画像、動画、音楽などの新しいコンテンツやアイデアを作成できるAIの一種で、機械学習モデルが使われている。生成系AIで使用される機械学習モデルとは、膨大な量のデータで事前にトレーニングされた大規模なモデルのことであり、「基盤モデル」という。

近年の機械学習の進歩(中でも、「Transformer」ベースのニューラルネットワークアーキテクチャの発明)によって、数十億個のパラメーターを含むモデルが台頭してきている。規模がどのくらい変わったのかというと、2019年に学習された最大のモデルは3億3000万個のパラメーターを有していた。それが現在では、最大規模のモデルのパラメーター数は5000億個を超えていて、わずか数年で、1600倍にも増大したことになるという。

大規模言語モデル(LLM)の「GPT 3.5」「BLOOM」といった基盤モデルや、テキストから画像を生成するStability AIの「Stable Diffusion」は、ブログ記事の作成や、画像の生成、数学の問題の解決、人との対話、文書に基づく質問への回答など、幅広いタスクを実行できる。基盤モデルの汎用(はんよう)性は、文章の感情分析や、画像の分類、トレンドの予測といった特定のタスクを実行する従来の機械学習モデルとは異なる。

はるかに多くのタスクを実行できる理由としては、基盤モデルは非常に多くのパラメーターを有し、複雑な概念の学習が可能だからだ。また、大規模なデータによる事前トレーニングを通じてさまざまな形態や数え切れないほどのパターンに触れることで、幅広いタスクで自らの知識を応用する方法を学ぶ。

モデルを一からトレーニングするのに比べてわずかなデータとコンピューティングリソースを使うだけで、カスタマイズできる。カスタマイズされた基盤モデルによって、銀行、旅行、ヘルスケアなど、さまざまな消費者産業におけるユーザーのニーズを形にすることで、独自の顧客体験を生み出せる。例えば、関連する全ての取引から日次で報告書を作成する必要がある金融会社の場合、独自のデータでモデルをカスタマイズし自動生成に活用できる。過去の報告書から、基盤モデルは報告書の解釈の仕方や、どのようなデータを使って報告書が作成されたのかを学習するという。

AWSのユーザーから、「企業や組織で基盤モデルや生成系AIを使い始めることで、生産性を新たなレベルにまで引き上げ、製品やサービスを変革するにはどうすればいいのか」という声が寄せられているという。

基盤モデルで簡単に生成系AIアプリを開発、拡張できるBedrockとTitanモデル

ユーザーからは、現在直面する幾つかの大きな課題が挙げられた。

- 自分たちの目的に最適で高パフォーマンスな基盤モデルを見つけてアクセスできる方法が必要

- 巨大なインフラを運用管理したり、膨大なコストを発生させたりすることなく、基盤モデルをアプリケーションに統合したい

- 基盤モデルを、自社データ(量の多少を問わず)を利用してカスタマイズすることで差別化したアプリケーションを構築できるようにしたい

ユーザーがカスタマイズに利用したいデータは極めて貴重なIPなので、処理中に完璧に保護され、安全性や機密性が保たれる必要があり、そうしたデータがどのように共有されたり、利用されたりするのかを自分たちでコントロールしたいと考えている。こうしたユーザーからのフィードバックを取り入れて、AWSはBedrockを発表したという。

Bedrockでできること

Bedrockはユーザーが基盤モデルを使って生成系AIベースのアプリケーションを構築、拡張する手法であり、全てのアプリケーション開発者が利用できる。Bedrockでユーザーはやろうとしていることに適切なモデルを簡単に見つけられるようになり、発見したモデルを迅速に自社独自のデータでカスタマイズしたり、使い慣れたAWSのツールや機能を使用して自社のアプリケーションに統合してデプロイしたりすることができる。

サーバレスで利用できるので、ユーザーが達成したいこと、すぐに始められること、自身のデータで基盤モデルをプライベートにカスタマイズしたいことに合わせて正しいモデルを選択し、AWSの使い慣れたツールと機能(例えば、異なるモデルを試す「Experiments」や大規模に基盤モデルを管理する「Pipelines」といった「Amazon SageMaker」の機械学習の機能)によって、インフラストラクチャを管理することなく、アプリケーションに統合、デプロイできる。

Bedrockで選択できる基盤モデル

Bedrockで選択できる基盤モデルにはAI21 Labsが提供する「Jurassic-2」ファミリーがある。Jurassic-2ファミリーは多言語に対応しており、スペイン語、フランス語、ドイツ語、ポルトガル語、イタリア語、オランダ語でテキストを生成できる。

Anthropicの「Claude」は、さまざまな種類の対話処理を実行できる基盤モデルだ。対話処理はいずれも「責任あるAI」のシステムを学習するためのAnthropicの幅広い研究に基づいている。

Stability AIのtext-to-image(テキストからの画像生成)基盤モデルも簡単に利用できるようになり、人気のあるStable Diffusionを活用して、独自画像やアート、ロゴ、デザインを生成できるようになる。

モデルのカスタマイズ

Bedrock機能の一つにモデルのカスタマイズの容易さがある。ユーザーは「Amazon Simple Storage Service」(S3)でラベル付けされたサンプルでBedrockを指示するだけで、特定のタスクに合わせてモデルを調整できる。大量のラベル付けデータを用意する必要はなく、20例程度のデータで十分だという。

データ保護

全てのデータは暗号化されて自社の「Amazon Virtual Private Cloud」(VPC)から出ることはないので、企業は自社データの個人情報や機密情報の保護について、信頼を置くことができる。

2つのTitan基盤モデル

Bedrockで選択できる基盤モデルの一つが、Titanだ。現在はプレビュー版で、2つのTitan基盤モデルを提供する予定。

1つ目は、要約やテキスト生成(ブログ記事の作成など)、分類、オープンエンドのQ&A、情報抽出などのタスクに向けた生成系基盤モデルだ。

2つ目が、テキスト入力(単語、フレーズ、もしくは大量のテキストユニット)を、テキストの意味を含む数値表現(「埋め込み表現」ともいう)に変換する基盤モデルだ。AWSは「この基盤モデルはテキストを生成しない代わりに、得られた埋め込み表現を比較することによって、単なる単語一致のマッチングよりもさらに文脈に沿った適切な対応が取れるので、パーソナライゼーションや検索などのアプリケーションに有用だAmazonの商品検索機能には同様の埋め込み表現に変換する基盤モデルが使われており、ユーザーが探している製品を見つけるために役立っている」としている。

責任あるAIを使用できるように制限も

責任あるAIを使用する際のベストプラクティスを継続的にサポートするために、Titan基盤モデルは顧客がカスタマイズ用に供給するデータ内にある有害なコンテンツを検出して削除したり、ユーザー入力の不適切なコンテンツを排除したり、不適切なコンテンツ(ヘイトスピーチや不適切な言葉、暴力など)を含むモデルのアウトプットにフィルターをかけるように構築されている。

AI専用チップを搭載するインスタンスの一般提供を開始

基盤モデルの学習から推論構築、カスタマイズまで、あらゆる作業において、機械学習に特化して構築された、最高の性能と費用対効果を発揮する基盤が求められている。この5年間、AWSは独自のシリコン開発に投資し、機械学習トレーニングや推論などの厳しいワークロードにおける性能と費用対効果の限界に挑んできた。

「AWS Trainium」と「AWS Inferentia」は、それぞれクラウド上でのモデルの学習と推論に用いる専用のチップとしてコストを節約する。最適な機械学習基盤を選択することで性能を最大化し、コストを管理できるAWSは、AI21 Labs、Anthropic、Cohere、Grammarly、Hugging Face、Runway、Stability AIといったAIスタートアップ企業に採用されている。

AI専用チップTrainiumを搭載するTrn1nインスタンス

Trainiumを搭載する「Trn1」インスタンスは、他のEC2インスタンスと比較して学習コストを最大50%削減するという。800Gbpsの第2世代Elastic Fabric Adapter(EFA)ネットワークで接続された複数のサーバで学習を分散化できるよう最適化されている。Trn1インスタンスは「UltraClusters」にデプロイすることで、最大3万個のTrainiumチップ(6ExaFlop以上の演算能力)まで拡張できる。

UltraClustersは、ペタビット級のネットワークを備えるAWSのアベイラビリティゾーンに構成される。HelixonやMoney ForwardといったAWSのユーザーやAmazon SearchチームでTrn1インスタンスを活用し、ディープラーニングモデルの学習に必要な時間を数カ月から数週間、あるいは数日に短縮しながらコストも削減しているという。

800Gbpsの帯域幅をさらに拡張するために取り組んできたAWSは、新たに、ネットワークに最適化されたTrn1nインスタンスの一般提供を開始した。ネットワーク負荷の高い大規模なモデル向けのインスタンスで、「1600Gbpsのネットワーク帯域幅を実現し、Trn1と比較して20%高い性能を提供する」としている。

現状では、多くのユーザーが基盤モデルの本番稼働を開始したばかりなので、基盤モデルに費やす時間とコストの大半は学習が占めているが、今後、基盤モデルが大規模に展開されと、コストの大半はモデルの稼働および推論に充てられる。モデルを定期的に学習させるとして、本番稼働では推論(予測)を、1時間当たり数百万という単位でコンスタントに生成することも起こり得る。推論にはリアルタイム性が求められ、非常に低レイテンシで高スループットのネットワークが必要となるという。例えば「Alexa」では、1分間に何百万件ものリクエストがあり、演算コスト全体の40%を占める。

AI専用チップInferentia2を搭載するInf2インスタンス

こうした背景の下、AWSは数年前に新たにチップ開発への投資を開始した際、推論に最適化したシリコンの開発を優先的に進めた。2018年に、推論に特化した初のチップである Inferentiaを発表した。Amazonは、Inferentiaによって年間で何兆もの推論を行い、数億ドルのコストを削減しているという。さらにAWSは、数千億のパラメーターを含む大規模なモデルの生成系AIアプリケーションに最適化されたInferentia2を搭載するInf2インスタンスの一般提供を開始した。

Inf2インスタンスは前世代のInferentiaのインスタンスと比較してスループットが最大4倍、レイテンシは最大10分の1となる。アクセラレーター間の超高速接続によって大規模な分散型の推論もサポートする。これによって、推論のコストパフォーマンスは他の同等のEC2インスタンスと比較して最大40%向上し、クラウド上の推論のコストを削減する。ユーザー企業のRunwayは、Inf2の導入によって、同等のEC2インスタンスと比較して幾つかのモデルでスループットが最大2倍向上している。

AIでコーディングを支援するCodeWhispererを個人開発者向けに無料提供

AWSが「生成系AIの活用が急速に拡大する」と見込んでいる領域の一つがコーディングだ。開発者は現在、平凡で一様なコードを書くのに多くの時間を費やしている一方で、複雑で常に変化するツールやテクノロジーに遅れず付いていくためにも多くの時間を割いている。このため、革新的な新機能やサービスの開発にかけられる時間が制限される。開発者はWeb上のコードスニペットをコピー、編集することでこれに対応しようとしているが、気付かないうちに、機能しないコードやセキュリティの脆弱(ぜいじゃく)性のあるコード、ライセンスを確認すべきオープンソースソフトウェア(OSS)のコードなどをコピーしてしまうこともある。また、その検索やコピーに時間が割かれてしまう。

生成系AIで画一的なコードの大半を「書く」ことでこの手間を解消し、開発者は、開発を迅速化しつつ、空いた時間でより創造性の求められるコードに集中できるようになる。

CodeWhispererでできること

このような背景から、AWSは2022年、統合開発環境(IDE)において開発者の自然言語によるコメントやこれまでのコードに基づき、内部で基盤モデルを活用してリアルタイムにコード候補を生成する、コーディング支援ツールのCodeWhispererのプレビュー版を発表した。例えば、開発者はCodeWhispererに対して「楽曲情報の文字列をCSV形式にパースして」などのタスクを要求し、アーティスト、タイトル、最高チャートランキングといった値に基づいて構造化リストを返すようにリクエストできる。

CodeWhispererは文字列をパースし、指定されたリストを返す一連の機能を生成することで生産性を向上させる。プレビュー時に実施した生産性チャレンジでは、CodeWhispererを利用した参加者のタスク完遂時間は、非利用者より平均で57%短縮され、タスク完遂率は27%高くなったという。

今回の一般提供開始で、Python、Java、JavaScript、TypeScript、C#の他、新たにGo言語、Kotlin、Rust、PHP、SQLなど10言語に対応。「Visual Studio Code」「IntelliJ IDEA」「AWS Cloud9」といったIDEから、IDE拡張機能の「AWS Toolkit」を介してアクセスできる。「AWS Lambda」のコンソールからも利用できる。

(自動推論による)セキュリティスキャンを内蔵、OSSライセンスも考慮

生成系AIが提案するコードに、セキュリティの脆弱性やOSSのライセンス違反が含まれていれば、開発者の生産性を真の意味で向上させることはできない。CodeWhispererは(自動推論による)セキュリティスキャンを内蔵し、OWASP(Open Worldwide Application Security Project)のトップ10に含まれる脆弱性や、暗号化ライブラリーのベストプラクティスを満たさないものなど、検出の困難な脆弱性を特定し修正案を提示する。

責任あるAIによるコーディングを支援するために、CodeWhispererは偏った、あるいは不公平と考えられるコードの提案を除外する。

CodeWhispererは、参照やライセンスが必要な可能性のあるOSSのコードに似たコード提案を除外したり、フラグを立てたりすることもできる。

個人ユーザー向けと企業ユーザー向けの違い

CodeWhispererは個人ユーザー向けには無料提供し、資格やコード生成の時間制限も設けていない。AWSアカウントがなくても、メールアカウントがあればCodeWhispererに登録できる。企業ユーザー向けには、「AWS Identity and Access Management」(IAM)と統合されたシングルサインオン(SSO)などの管理機能を搭載し、セキュリティスキャンの上限を引き上げた「Amazon CodeWhisperer Professional Tier」を用意している。

関連記事

Google Cloud、生成AI活用を支援する「Vertex AI」の強化と「Generative AI App Builder」を発表

Google Cloud、生成AI活用を支援する「Vertex AI」の強化と「Generative AI App Builder」を発表

Google Cloudは、生成AIアプリケーションを簡単に構築できるツールを求める企業のニーズに応え、Google Cloudの機械学習プラットフォーム「Vertex AI」での生成AIサポートと、新ツール「Generative AI App Builder」を発表した。 新発表のMicrosoft 365 CopilotはChatGPTを付けただけじゃない、パワポ自動作成などの活用例をMicrosoftが紹介

新発表のMicrosoft 365 CopilotはChatGPTを付けただけじゃない、パワポ自動作成などの活用例をMicrosoftが紹介

Microsoftが、Microsoft 365にChatGPTのようなインタフェースを統合した「Microsoft 365 Copilot」を発表した。発表イベントでMicrosoftが説明した新製品のさまざまな使い方を紹介する。 大規模なインフラを自由に使えないAI研究者向けに、Metaが「小規模で高性能な言語モデル」を公開

大規模なインフラを自由に使えないAI研究者向けに、Metaが「小規模で高性能な言語モデル」を公開

Metaは、同社開発した言語モデル「LLaMA」(Large Language Model Meta AI)を研究者向けに公開した。「人間の文章生成に似た方法で文章を生成できる」という。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.