Embedding(エンベディング:埋め込み、埋め込み表現)とは?:AI・機械学習の用語辞典

用語「Embedding(埋め込み)」について説明。単語やテキスト、画像を、AI/言語モデルが扱いやすい数値ベクトル(例:[0.4, -0.1, 0.2, ...])に変換する技術のこと。Word Embedding(単語の埋め込み)では、意味的に近い単語同士がベクトル空間上で近接するように変換される。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

用語解説

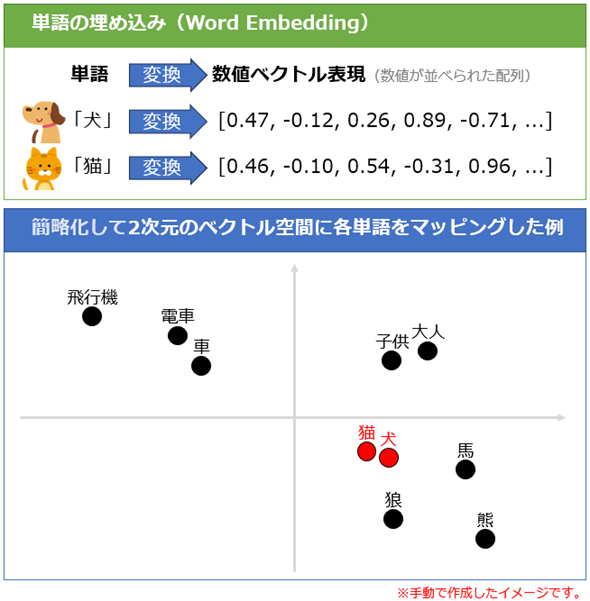

AI/機械学習/自然言語処理における埋め込み(Embedding:エンベッディング、もしくはエンベディング)とは、主に単語や文章(テキスト)、画像、音声などの複雑なデータを、AI/機械学習/言語モデルが処理しやすい数値ベクトル表現に変換する技術である。この数値ベクトル表現は「埋め込み表現(Embeddings)」とも呼ばれる。なお、数値ベクトルとは、例えば[0.47, −0.12, 0.26, 0.89, −0.71, ...]のように実数値が並べられた配列のことで、例えば100個の数値が並ぶ場合は「100次元」とも表現できる。

埋め込みの基礎的な例は「単語の埋め込み(Word Embedding)」で、これは「意味的に関連する単語同士」を「空間的に近い数値ベクトル」へと変換することを指す。その変換プロセスでは、各単語を意味的に濃縮された低次元のベクトル空間(例えば100次元)へ数学的にマッピングする。例えば(図解するために極端に簡略化して)2次元のベクトル空間に埋め込む場合は、X軸とY軸の座標空間上に点を打つようなイメージとなる(図1:「犬」と「猫」という意味的に似た単語が空間内で近い位置に配置されていることに注目してほしい)。

なお、図1では2次元に簡略化したが、実際の埋め込みではより多くの次元(word2vecなど従来の手法では通常50〜300次元、BERTなど最近の大規模言語モデルでは通常768〜1024次元以上)を使用することで、単語の意味やニュアンスをより詳細に捉えられる。

「単語の埋め込み」の歴史

自然言語処理で単語を数値ベクトルとして表現する方法には、主にBag of Wordsと分散表現の2種類がある。Bag of Words(BoW)は「単語の出現頻度」でベクトル化する方法で、tf-idf(term frequency - inverse document frequency)がその代表例である。一方、分散表現(Distributed Representations)は「(単語の)意味」でベクトル化する方法で、本稿で説明している「埋め込み」はこちらを指し、word2vecやGloVe、BERT、text-embedding-ada-002モデルなどがその代表例だ(いずれも後述)。

単語を分散表現するアイデアは、「単語の意味は、その周辺に現れる単語(つまりコンテキスト)によって形成される」とした言語学における分布仮説(Distributional hypothesis)が、1954年に登場したことに始まる。それから、単語や文章の隠れた(=潜在的な)意味関係を抽出する潜在意味解析(LSA:Latent Semantic Analysis)というベクトル表現の手法が1990年に登場した。

分散表現の研究が大きく進むきっかけとなったのが、ディープラーニングにより「単語レベルの埋め込みモデル」(Word Embedding Model:単語埋め込みモデル)を作成できるword2vec(word to vector、ワード・ツー・ヴェック)という手法で、Googleが2013年に発表した。また、より高速で高性能な「単語埋め込みモデル」を作成できるGloVe(Global Vectors for Word Representation、グローヴ)という手法が、スタンフォード大学により2014年に発表されている。

その後、さらに高性能で文脈を考慮した「テキストレベルの埋め込みモデル」(Text Embedding Model:テキスト埋め込みモデル)としても機能するBERT(Bidirectional Encoder Representations from Transformers)が、Googleにより2018年10月に発表された。最近では、大規模言語モデルに独自の検索機能を付加する場合などで役立つtext-embedding-ada-002という「テキスト埋め込みモデル」が、OpenAIにより2022年12月にリリースされている。これらはあくまで一例であり、最近では各所から埋め込みモデルが公開されている。

単語/テキストからマルチモーダルへ

さらに最近では、テキストデータだけでなく画像や音声などのデータ(=複数のモダリティ)も含めたマルチモーダルな埋め込みモデルも開発されてきており、AIの応用範囲を大きく広げている。例えば、2021年1月に登場したOpenAIのCLIP(Contrastive Language-Image Pre-training)という埋め込みモデルは、テキストと画像の両方から埋め込み表現を生成し、それにより両者の関連性が把握できる(参考:実際に埋め込み表現を生成する例)。このように扱うデータが多様化するなど、今後も「埋め込み」に関する技術は進化していくだろう。

注意点としては、埋め込みモデルが元のデータの偏りや不正確さを反映する可能性があることである。例えば、訓練データに含まれる偏見やステレオタイプがモデルに継承される問題がある。これにより、モデルが不公平な結果を生み出す恐れがある。これらの問題に対処するための研究も活発に進められている。

Copyright© Digital Advantage Corp. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ