大規模言語モデル(LLM)の評価と比較のポイント:Gartner Insights Pickup(375)

「ChatGPT」の急速な浸透に伴い大規模言語モデル(LLM)が急増し、それらを評価することが課題となっている。本稿ではLLMを評価、比較するための重要な要素と、LLMが自社にもたらす効果と推奨事項を紹介する。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

「ChatGPT」の急速な浸透に伴い、大規模言語モデル(LLM)が急増し、それらを評価することが重要課題となっている。LLMは多面的な性質を持っているため、企業がLLMを評価し、自社に最適なモデルを選択するための万能のアプローチは存在しない。各LLMには測定すべきさまざまな側面があり、企業には特定のユースケースに基づく固有の優先順位がある。

こうした複雑さがあるものの、どのようなLLMも導入する前に徹底的な評価を行うことは極めて重要だ。以下では、LLMを評価、比較するための重要な要素を概説し、LLMが自社にもたらす効果を測定し、向上させるのに役立つ推奨事項を紹介する。

モデルの種類:汎用(はんよう)vs.ドメイン固有

LLMを効果的に比較するには、個々のLLMが汎用的なものか、あるいは与えられたタスクやコンテキストに特化したものかを理解することが極めて重要だ。通常、汎用的なLLM(OpenAIのGPTモデルなど)は、幅広い一般的なユースケースをサポートする。特定の業界、ビジネス機能、またはタスクに特化したトレーニングは施されていない。これに対し、ドメイン(業界やビジネス機能)固有LLMは、特定のタスクやドメインに関する専門知識を身につけるために、特殊なデータセットでトレーニングされたり、ファインチューニングされたりしている。

リーダーは、自社に適したLLMを選択するために、これらのモデルの一般的なユースケースを把握しておく必要がある。

- 汎用モデル:一般的に、広範な自然言語理解と生成タスク(コンテンツ作成や要約など)に使用される。プロンプトエンジニアリング(コンテキスト内学習など)によって、ドメイン固有モデルに比べて優れた能力と柔軟性を発揮する場合が多い

- ドメイン固有モデル:特定のドメイン(水平または垂直)、組織、またはタスク向けに設計されている。特定の業界や分野に関する深い知識を持ち、トレーニングされることで専門的なタスク(コーディング、翻訳、文書理解など)に秀でる

LLMベースの包括的なソリューションを構築するには、単一のLLMではなく、複数のLLMが必要になる可能性がある。汎用モデルとドメイン固有モデルの両方、さらには他の種類のモデルも必要かもしれない。これらのLLMはソリューション内で異なる役割を担い、さまざまな方法で“協働”することになるだろう。

モデルの能力評価:ベンチマークとテストケース

LLMの評価については幾つかのベンチマークやリーダーボードが利用可能であり、それらにはコミュニティーベースのものとモデルメーカーが提供するものがある。

汎用モデルでは、LMSYS Org(Large Model Systems Organization)の「Chatbot Arena(※)」が、能力評価のために参照できる有益なリーダーボードとなっている。これはクラウドソーシングによるオープンなプラットフォームであり、ユーザーは多数のLLMから自動的に選択された2つの匿名のLLMに対し、チャットで自由に同じ質問をし、回答に基づいてどちらが優れているかを判定して投票する。投票するまで、2つのLLMとチャットを続けることが可能だ。

モデルメーカーは、全ての質問に関する予備知識を持つことはできず、ランキングの順位を上げるために、質問の傾向に合わせたモデルのトレーニングやファインチューニングは不可能だ。このため、Chatbot Arenaは、さまざまなモデルの一般的な能力を評価し、比較するための便利な出発点となる。

通常、モデルメーカーは新しいモデルをリリースする際、ベンチマーク結果を提供する。企業がモデルの特定の能力に注目している場合、特定のタスクに特化したベンチマーク結果が有用な参考資料となることがある。

だが、多くの場合、公開されているLLMベンチマークにはデータ漏えいの問題が付きまとう点に注意することが重要だ。これは、評価用のデータセットが何らかの事情で、トレーニングデータセットに含まれてしまうというものだ。こうしたデータセットでトレーニングされたモデルのベンチマーク結果は、モデルの実際の性能を正確に反映しないことがある。

企業は、ベンチマーク結果やリーダーボードを参照するだけでなく、自社の特定のユースケースに沿った独自の機能テストケースを開発する必要もある。そのためにはまず、各ユースケースの範囲と目的を明確に定義する。LLMの適用範囲が広いと、望ましくない動作のリスクが高くなる場合があるからだ。

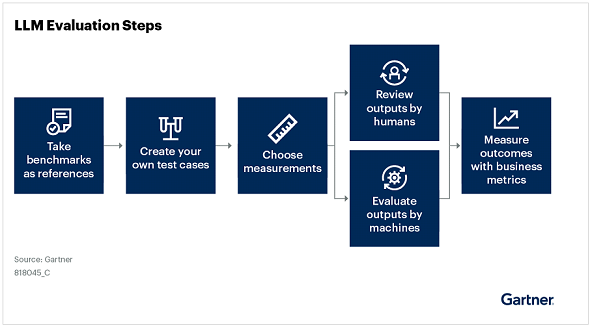

テストケースでは、不適切なシナリオでLLMを使用しないことが重要だ。本番環境でのLLMの使用シナリオを忠実に反映したテストケースを作成し、質問と回答のペアなど、そのシナリオと類似または同一のデータを使用するとよい。可能な限り、適正に評価するためだ。下の図は、LLMの評価プロセスを示している。

テストケースを作成したら、テストケースで何を測定するかを検討する。LLMの適用範囲は多岐にわたるが、テストケースでは一般的に、正確性、コンテキストとの関連性、安全性など、特定のユースケースに即した指標を測定できる。ビジネス要件に基づいてこれら全てに優先順位を付けなければならない。

モデルの能力評価とは別に、利用料金や速度、IP(知的財産)補償、デプロイ(展開)アプローチのような非機能的な要素を検討する必要もある。これらの要素は、LLMの評価に不可欠だ。規制要件や厳格なセキュリティ要件がある企業では、オンプレミスでデプロイする必要があり、そのためにモデルの選択肢が限られる場合は特にそうだ。

またリーダーは、選択したモデルが自社固有のニーズや制約に合致するように、精度、推論コスト、推論速度、コンテキストウィンドウサイズといった特性間のトレードオフを比較検討しなければならない。

出典:Comparing and Evaluating Large Language Models(Gartner)※この記事は、2024年9月に執筆されたものです。

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

編集部からのお知らせ